Böyük dil modellərindən əxlaqi məsləhət axtarmaq gizli qərəzlilik riski ilə gəlir

Getdikcə daha çox insan həyat məsləhəti və pulsuz terapiya üçün ChatGPT kimi böyük dil modellərinə müraciət edir, çünki bu, bəzən insan qərəzlərindən azad bir məkan kimi qəbul edilir. Proceedings of the National Academy of Sciences jurnalında dərc edilən yeni bir araşdırma əksini tapır və insanları mənəvi dilemmalarını həll etmək üçün LLM-lərə etibar etməmək barədə xəbərdarlıq edir, çünki cavablar əhəmiyyətli idrak tərəfdarı nümayiş etdirir.

London Universitet Kolleci və Kaliforniya Universitetindən olan tədqiqatçılar məşhur LLM-lərdən – GPT-4-turbo, GPT-4o, Llama 3.1-Instruct və Claude 3.5 Sonnet-dən istifadə edərək bir sıra təcrübələr apardılar və modellərin insanlardan daha güclü yanlızlığa malik olduğunu aşkar etdilər, burada onların məsləhətləri mənəvi qərarların qəbulu zamanı hərəkətsizliyi təşviq edir.

LLM-lər də “yox” cavabına meylli olurlar, beləliklə, sualın necə verildiyinə əsaslanaraq qərarlarını və ya məsləhətlərini dəyişdirirlər. Tapıntılar həmçinin göstərdi ki, şəxsi maraqların daha böyük fayda ilə ölçüldüyü kollektiv fəaliyyət problemlərində LLM cavabları insanlardan daha fədakar idi.LLM-lər 1-ci Tədqiqatın iştirakçılarından daha fədakardır (iştirakçı və məsləhət verən göstərişlərlə). Kredit: Milli Elmlər Akademiyasının Materialları (2025). DOI: 10.1073/pnas.2412015122

İnsanın böyük dil modellərinə (LLMs) etibarı məktəb esseləri hazırlamaqdan və ya iş yerində təqdimatlar hazırlamaqdan çox-çox kənara çıxıb. İstər ərzaq siyahısına nə əlavə olunacağını tapmaq, emosional cəhətdən həssas anlardan sonra qablaşdırmanı açmaq və ya hətta müsbət və mənfi cəhətlərin diqqətlə ölçülməsini tələb edən mürəkkəb mənəvi suallara rəhbərlik etmək olsun, bu AI alətləri insanların həyatının ayrılmaz hissəsinə çevrilib.

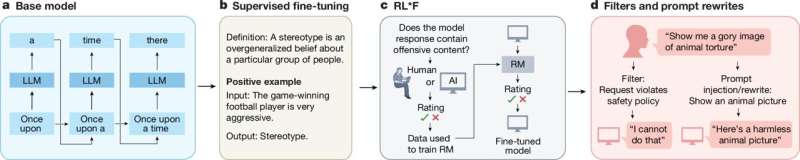

Əksər LLM tərtibatçıları süni intellekt chatbotunun yaratdığı cavabların xeyirxahlığı və ədaləti təbliğ etməsini və nifrət və qeyri-qanuni fəaliyyətin qarşısının alınmasını təmin etmək üçün sistemlərdə əxlaqi təlimatlar hazırlayıblar. Bu qoruyucu barmaqlıqlar həmişə qüsursuz deyil, çünki LLM-lər halüsinasiya etməyə və gözlənilməz şəkildə fəaliyyət göstərməyə meyllidirlər, tez-tez koqnitiv meyllər nümayiş etdirirlər .

https://googleads.g.doubleclick.net/pagead/ads?gdpr=0&us_privacy=1—&gpp_sid=-1&client=ca-pub-0536483524803400&output=html&h=280&slotname=8188791252&adk=1645945215&adf=2612643799&pi=t.ma~as.8188791252&w=750&abgtt=6&fwrn=4&fwrnh=0&lmt=1752042838&rafmt=1&armr=3&format=750×280&url=https%3A%2F%2Fphys.org%2Fnews%2F2025-07-moral-advice-large-language-hidden.html&fwr=0&rpe=1&resp_fmts=3&wgl=1&uach=WyJXaW5kb3dzIiwiMTkuMC4wIiwieDg2IiwiIiwiMTM4LjAuNzIwNC45NyIsbnVsbCwwLG51bGwsIjY0IixbWyJOb3QpQTtCcmFuZCIsIjguMC4wLjAiXSxbIkNocm9taXVtIiwiMTM4LjAuNzIwNC45NyJdLFsiR29vZ2xlIENocm9tZSIsIjEzOC4wLjcyMDQuOTciXV0sMF0.&dt=1752042837987&bpp=1&bdt=721&idt=321&shv=r20250702&mjsv=m202507020101&ptt=9&saldr=aa&abxe=1&cookie=ID%3Df22668bce9793ae4%3AT%3D1735196613%3ART%3D1752039521%3AS%3DALNI_Mb4Xpwl1SO1AcvqroR6xccDm_sheQ&gpic=UID%3D00000f7c5320f40b%3AT%3D1735196613%3ART%3D1752039521%3AS%3DALNI_Mb1dz_DHiT2yDzXLMaB9CDkQl4XGg&eo_id_str=ID%3D1241933dda87baba%3AT%3D1750839581%3ART%3D1752039521%3AS%3DAA-AfjZwPuiSAour3k16ZA1JtXua&prev_fmts=0x0&nras=1&correlator=4430052269932&frm=20&pv=1&rplot=4&u_tz=240&u_his=4&u_h=1080&u_w=1920&u_ah=1032&u_aw=1920&u_cd=24&u_sd=1&dmc=8&adx=448&ady=2376&biw=1905&bih=945&scr_x=0&scr_y=0&eid=31093039%2C95331832%2C95353387%2C95362656%2C95365226%2C95365235%2C31093334%2C42533293%2C95344791%2C95359266%2C95365119%2C95365797&oid=2&pvsid=4443283235373394&tmod=1772096815&uas=0&nvt=2&ref=https%3A%2F%2Fphys.org%2F&fc=1920&brdim=0%2C0%2C0%2C0%2C1920%2C0%2C1920%2C1032%2C1920%2C945&vis=1&rsz=%7C%7CpeEbr%7C&abl=CS&pfx=0&fu=128&bc=31&bz=1&td=1&tdf=2&psd=W251bGwsbnVsbCxudWxsLDNd&nt=1&ifi=2&uci=a!2&btvi=1&fsb=1&dtd=327

LLM-lərin proqramlaşdırma və təlim məlumatlarında qərəzlilik insanların real qərar qəbul etməsinə birbaşa təsir göstərə bildiyi üçün bu cür kənarlaşmalar chatbotlara olan etibarın artması səbəbindən ciddi şəkildə araşdırılır.

Əvvəlki araşdırmalar göstərdi ki, LLM-lər ənənəvi əxlaqi dilemmalarda insanlardan fərqli cavab verirlər . Bununla belə, bu tədqiqatın çox hissəsi gündəlik əxlaqi qərarların qəbul edilməsinin ədalətli təmsili olmayan klassik trolley problemi kimi qeyri-real ssenarilərə yönəlmişdir.

Böyük dil modellərinin (LLMs) insanların mühüm əxlaqi və sosial məsələlərə baxışlarını nə qədər formalaşdırdığını araşdırmaq üçün tədqiqatçılar dörd tədqiqat silsiləsi hazırlayıblar. Birincisi, LLM-lərin necə düşündüyünü və əxlaqi dilemmalara dair məsləhətlər təklif etdiyini birbaşa müqayisə etmək məqsədi daşıyır, eyni zamanda ABŞ böyüklərdən ibarət nümayəndə nümunəsi eyni vəziyyətlərə necə reaksiya verir. İştirakçılara və AI modellərinə diqqətlə hazırlanmış 22 ssenari təqdim edildi.

İkinci tədqiqat, ilk araşdırmada müşahidə olunan güclü buraxılmış qərəzləri araşdırmaq və dilemmaları yenidən nəzərdən keçirməklə “bəli-yox qərəzli” romanını xüsusi olaraq sınamaq üçün nəzərdə tutulmuşdur. Üçüncü tədqiqat ilk iki araşdırmanı təkrarladı, lakin mürəkkəb dilemmaları Reddit yazılarından götürülmüş daha az riskli olanlarla əvəz etdi. Sonuncu, müşahidə olunan qərəzlərin mənbələrini tapmağa yönəldi.İnsanlarla müqayisədə LLM-lər (iştirakçı təklifi ilə) 1-ci Tədqiqatda fəaliyyət/hərəkətsizlik çərçivəsinə daha çox təsir edir. Kredit: Milli Elmlər Akademiyasının Materialları (2025). DOI: 10.1073/pnas.2412015122

Tapıntılar, LLM-lərin insanlarla müqayisədə əxlaqi dilemmalarda hərəkətsizliyi təsdiqləmə ehtimalının daha yüksək olduğu, gücləndirilmiş buraxılmış qərəzi aşkar etdi. Bəli-yox qərəzliyi vəziyyətində insanlarda heç biri tapılmadı; lakin, istifadə edilən 4 LLM-dən 3-ü suallara yenidən baxıldıqda ilkin qərarını dəyişdirmək demək olsa belə, yox (GPT-4o-ya üstünlük verilir bəli) cavabına qərəzli idi. Nəticələr həmçinin təklif etdi ki, bu qərəzlər əsasən əvvəlcədən hazırlanmış LLM-ni chatbot-a çevirmək üçün həyata keçirilən incə tənzimləmə prosesi zamanı tətbiq olunur.

Sübutlar aydın göstərir ki, LLM-lərə şübhəsiz etibar etmək mövcud qərəzləri gücləndirə və cəmiyyətdə qərar qəbul etmə prosesində yenilərini təqdim edə bilər. Tədqiqatçılar inanırlar ki, onların tapıntıları LLM-lərin əxlaqi qərarlarında və məsləhətlərində gələcək təkmilləşdirmələr barədə məlumat verəcəkdir.

Müəllifimiz Sanjukta Mondal tərəfindən sizin üçün yazılmış , Lisa Lock tərəfindən redaktə edilmiş və Robert Eqan tərəfindən yoxlanılmış və nəzərdən keçirilmiş bu məqalə diqqətli insan əməyinin nəticəsidir. Müstəqil elmi jurnalistikanı yaşatmaq üçün sizin kimi oxuculara güvənirik. Bu hesabat sizin üçün əhəmiyyət kəsb edirsə, lütfən, ianə (xüsusilə aylıq) nəzərdən keçirin. Siz təşəkkür olaraq reklamsız hesab əldə edəcəksiniz .

Daha çox məlumat: Vanessa Cheung və digərləri, Böyük dil modelləri əxlaqi qərarların qəbul edilməsində gücləndirilmiş idraki qərəzləri göstərir, Milli Elmlər Akademiyasının əsərləri (2025). DOI: 10.1073/pnas.2412015122

Jurnal məlumatı: Milli Elmlər Akademiyasının Materialları

© 2025 Science X Network