ChatGPT sizə diaqnoz qoya bilərmi? Yeni tədqiqat vəd verir, lakin bilik boşluqları və halüsinasiyalar problemlərini ortaya qoyur

Chris Kocher, Binghamton Universiteti

Gaby Clark tərəfindən redaktə edilmişdir , Andrew Zinin tərəfindən nəzərdən keçirilmişdir

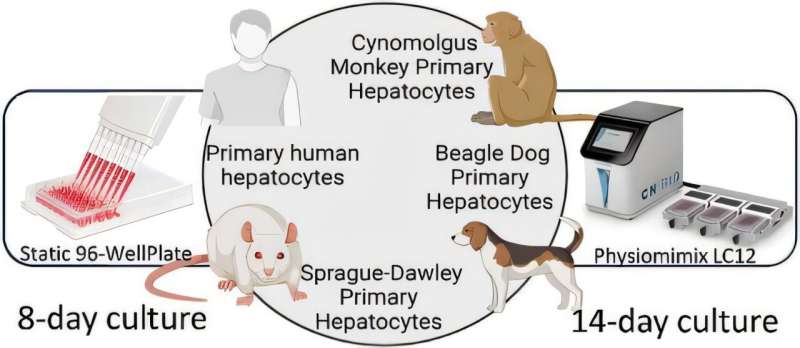

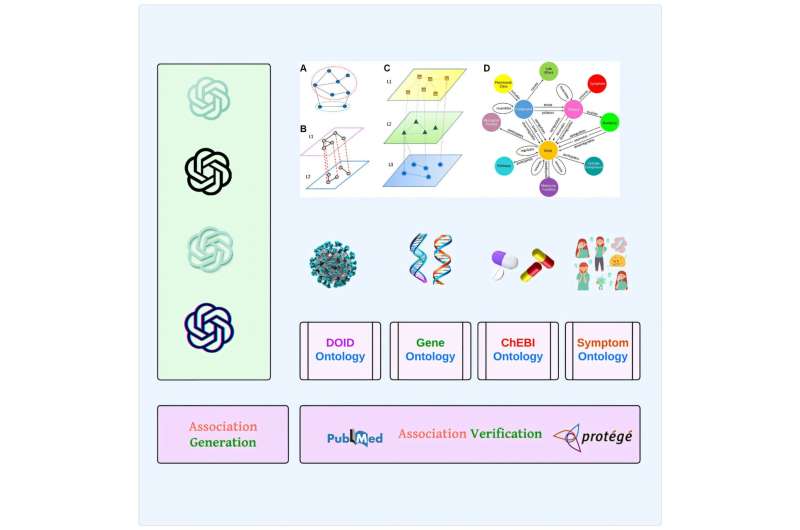

Redaktorların qeydləriQrafik abstrakt. Kredit: iScience (2025). DOI: 10.1016/j.isci.2025.112492

İnsanlar xəstələndiklərindən narahat olduqda, diaqnoz üçün getdikcə daha çox ChatGPT kimi generativ süni intellektə müraciət edirlər. Bəs AI-nin verdiyi cavablar nə dərəcədə doğrudur?

Bu yaxınlarda iScience jurnalında dərc edilən araşdırma ChatGPT və onun böyük dil modellərini bir neçə təəccüblü nəticə ilə sınaqdan keçirir.

Əhməd Abdeen Hamed – Tomas J. Watson Mühəndislik və Tətbiqi Elmlər Kollecinin Sistem Elmi və Sənaye Mühəndisliyi fakültəsinin Binghamton Universitetində elmi işçisi – Polşanın Krakov AGH Universitetinin əməkdaşları ilə aparılan tədqiqata rəhbərlik etmişdir; Howard Universiteti; və Vermont Universiteti.

Corc J. Klir Sistem Elmi Professoru Luis M. Rochanın Kompleks Adaptiv Sistemlər və Hesablama İntellekt Laboratoriyasının bir hissəsi kimi Hamed keçən il xFakeSci adlandırdığı maşın öyrənmə alqoritmini inkişaf etdirdi. O, saxta elmi məqalələrin 94%-ni aşkar edə bilir – bu, daha çox yayılmış məlumatların öyrənilməsi üsullarından təxminən iki dəfə uğurludur. O, bu yeni tədqiqatı böyük dil modellərinin biotibbi generativ imkanlarını yoxlamaq üçün növbəti addım kimi görür.

“İnsanlar bu günlərdə ChatGPT ilə hər zaman danışır və deyirlər: “Məndə bu əlamətlər var. Məndə xərçəng varmı? Ürəyim dayanıbmı? Müalicə almalıyam?”” Hamed deyib. “Bu, çox təhlükəli bir iş ola bilər, ona görə də bu sualları versək nə baş verəcəyini, hansı cavabları aldığımızı və bu cavabların biotibbi ədəbiyyatdan necə yoxlanılacağını görmək istədik .”

Tədqiqatçılar ChatGPT-ni xəstəlik şərtləri və üç növ assosiasiya üçün sınaqdan keçirdilər: dərman adları, genetika və simptomlar. Süni intellekt xəstəlik terminlərini (88-97%), dərman adlarını (90-91%) və genetik məlumatı (88-98%) müəyyən etməkdə yüksək dəqiqlik göstərdi. Hamed bunun “ən çox 25% dəqiqlik” olacağını düşündüyünü etiraf etdi.

“Maraqlı nəticə ChatGPT-nin dediyinə görə xərçəng bir xəstəlikdir, hipertoniya bir xəstəlikdir, qızdırma bir simptomdur, Remdesivir dərmandır və BRCA döş xərçəngi ilə əlaqəli bir gendir” dedi. “İnanılmaz, tamamilə inanılmaz!”

Simptomların identifikasiyası isə daha aşağı nəticə göstərdi (49-61%) və bunun səbəbi böyük dil modellərinin necə öyrədilməsi ola bilər. Həkimlər və tədqiqatçılar ardıcıl məlumatların təqdim edilməsi və bilik mübadiləsi üçün şərtləri və əlaqələri müəyyən etmək və təşkil etmək üçün biotibbi ontologiyalardan istifadə edirlər, lakin istifadəçilər daha çox qeyri-rəsmi təsvirlər daxil edirlər.

“ChatGPT daha çox mehriban və sosial dildən istifadə edir, çünki o, adi insanlarla ünsiyyət qurmalı idi. Tibbi ədəbiyyatda insanlar uyğun adlardan istifadə edirlər” dedi Hamed. “LLM, görünür, bu simptomların tərifini sadələşdirməyə çalışır, çünki bu cür suallar verən çoxlu trafik var, buna görə də həmin istifadəçilərə müraciət etmək üçün tibbi dilin formallıqlarını minimuma endirməyə başladı.”

Bir çaşdırıcı nəticə diqqət çəkdi. Milli Sağlamlıq İnstitutları hər müəyyən edilmiş DNT ardıcıllığına qoşulma nömrəsi verən GenBank adlı verilənlər bazasını saxlayır. Adətən hərf və rəqəmlərin birləşməsidir. Məsələn, Döş Xərçəngi 1 geni (BRCA1) üçün təyinat NM_007294.4-dür.

Genetik məlumat testinin bir hissəsi olaraq bu nömrələri soruşduqda, ChatGPT onları sadəcə uydurdu – “hallüsinasiya” kimi tanınan bir fenomen. Hamed bunu bir çox müsbət nəticələr arasında böyük bir uğursuzluq olaraq görür.

“Bəlkə burada bir fürsət var ki, biz bu biotibbi ontologiyaları daha yüksək dəqiqlik təmin etmək, bütün halüsinasiyalardan xilas olmaq və bu alətləri heyrətamiz bir şeyə çevirmək üçün LLM-lərə təqdim etməyə başlayaq” dedi.

Hamedin LLM-lərə marağı 2023-cü ildə ChatGPT-ni kəşf etdikdən və faktların yoxlanılması ilə bağlı məsələlər haqqında eşitdikdə başladı. Onun məqsədi çatışmazlıqları üzə çıxarmaqdır ki, məlumat alimləri modelləri lazım olduqda tənzimləyə və onları daha yaxşı edə bilsinlər.

“Mən biliyi təhlil edirəmsə, nəzəriyyələrimi qurmadan və dəqiq olmayan bir şey yaratmazdan əvvəl balıq kimi görünə biləcək hər şeyi sildiyimə əmin olmaq istəyirəm” dedi.

Daha çox məlumat: Əhməd Abdeen Hamed və digərləri, Bilik nəslindən biliyin yoxlanışına qədər: ChatGPT, iScience (2025) biyomedikal generativ imkanlarının araşdırılması . DOI: 10.1016/j.isci.2025.112492

Jurnal məlumatı: iScience Binghamton Universiteti tərəfindən təmin edilmişdir