Dinamik model real insan hərəkətləri yarada və mövcud olanları redaktə edə bilər

İnsanlar ətraflarını araşdırarkən, başqaları ilə ünsiyyət qurarkən və özlərini ifadə edərkən çoxlu bədən hərəkətləri edə bilirlər. Bu hərəkətləri real surətdə təkrarlamaq, onları insan və insanabənzər personajlara tətbiq etmək bacarığı video oyunların inkişafı və animasiyaların, virtual reallıq (VR) qulaqlıqlarından istifadə etməklə baxıla bilən məzmunun və peşəkarlar üçün təlim videolarının yaradılması üçün çox dəyərli ola bilər.

Pekin Universitetinin Süni İntellekt İnstitutunun (AI) və Ümumi Süni İntellektin Dövlət Açar Laboratoriyasının tədqiqatçıları bu yaxınlarda insan personajları və ya avatarları üçün real hərəkətlərin yaradılmasını sadələşdirə biləcək yeni modellər təqdim ediblər. Əsər arXiv preprint serverində dərc olunur .

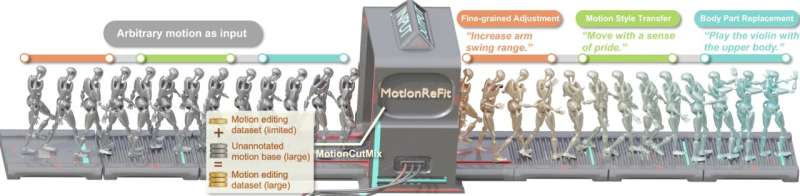

CVPR 2025- də təqdim olunan məqalədə təsvir edilən insan hərəkətlərinin yaradılması üçün onların təklif etdiyi yanaşma MotionCutMix adlı məlumat artırma texnikasına və MotionReFit adlı diffuziya modelinə əsaslanır .

” Süni intellekt və kompüter görməsinin kəsişməsini araşdıran tədqiqatçılar olaraq , mətndən hərəkətə nəsildə son nailiyyətlər – mətn təsvirlərindən insan hərəkətlərini yarada bilən sistemlər bizi valeh etdi” dedi.

“Lakin biz texnoloji mənzərədə kritik boşluq müşahidə etdik. Sıfırdan hərəkətlər yaratmaq böyük irəliləyiş əldə etsə də, mövcud hərəkətləri redaktə etmək imkanı ciddi şəkildə məhdud olaraq qaldı.”

Rəssamlar, video oyun tərtibatçıları və animasiya kinorejissorları adətən tamamilə sıfırdan yeni məzmun yaratmırlar, əksinə əvvəlki işlərdən ilham alır, onları təkmilləşdirir və istədikləri nəticələrə çatana qədər düzəldirlər. Mövcud süni intellekt və maşın öyrənmə sistemlərinin əksəriyyəti bu redaktə və ilham əsaslı yaradıcı iş axını dəstəkləmək üçün nəzərdə tutulmayıb.

https://googleads.g.doubleclick.net/pagead/ads?gdpr=0&us_privacy=1—&gpp_sid=-1&client=ca-pub-0536483524803400&output=html&h=188&slotname=2793866484&adk=1121470953&adf=746485419&pi=t.ma~as.2793866484&w=750&abgtt=6&fwrn=4&lmt=1744615359&rafmt=11&format=750×188&url=https%3A%2F%2Ftechxplore.com%2Fnews%2F2025-04-dynamic-generate-realistic-human-motions.html&wgl=1&uach=WyJXaW5kb3dzIiwiMTkuMC4wIiwieDg2IiwiIiwiMTM1LjAuNzA0OS44NSIsbnVsbCwwLG51bGwsIjY0IixbWyJHb29nbGUgQ2hyb21lIiwiMTM1LjAuNzA0OS44NSJdLFsiTm90LUEuQnJhbmQiLCI4LjAuMC4wIl0sWyJDaHJvbWl1bSIsIjEzNS4wLjcwNDkuODUiXV0sMF0.&dt=1744615354251&bpp=1&bdt=1869&idt=1123&shv=r20250410&mjsv=m202504080101&ptt=9&saldr=aa&abxe=1&cookie=ID%3Dfdc40d724f2dca57%3AT%3D1735367325%3ART%3D1744615355%3AS%3DALNI_MYStQ6fUQQQLyo5Z7z1h-XhXcWBtA&gpic=UID%3D00000f80eacffadc%3AT%3D1735367325%3ART%3D1744615355%3AS%3DALNI_MYaOugky0UawScoidzfbXof3-N-iw&eo_id_str=ID%3De43bb863646b60b8%3AT%3D1735367325%3ART%3D1744615355%3AS%3DAA-AfjbQoPwZqH28q9IwcCLRSzzg&prev_fmts=0x0%2C1905x945&nras=2&correlator=5715582912422&frm=20&pv=1&rplot=4&u_tz=240&u_his=1&u_h=1080&u_w=1920&u_ah=1032&u_aw=1920&u_cd=24&u_sd=1&dmc=8&adx=448&ady=1503&biw=1905&bih=945&scr_x=0&scr_y=0&eid=95355973%2C95355975%2C42532524%2C95357877%2C95356661%2C95356809%2C95357715&oid=2&pvsid=2913821879374313&tmod=310472353&uas=0&nvt=1&ref=https%3A%2F%2Fphys.org%2F&fc=1920&brdim=0%2C0%2C0%2C0%2C1920%2C0%2C1920%2C1032%2C1920%2C945&vis=1&rsz=%7C%7CpeEbr%7C&abl=CS&pfx=0&fu=128&bc=31&bz=1&td=1&tdf=2&psd=W251bGwsbnVsbCxudWxsLDNd&nt=1&ifi=2&uci=a!2&btvi=1&fsb=1&dtd=5637

“Hərəkəti redaktə etməyə cəhd edən əvvəllər hazırlanmış sistemlər əhəmiyyətli bir məhdudiyyətlə üzləşdi, yəni onlar orijinal hərəkətlərin, redaktə edilmiş hərəkətlərin və müvafiq təlimatların əvvəlcədən toplanmış üçqatlarını tələb edirdilər – yaratmaq üçün son dərəcə az və bahalı olan məlumatlar” dedi məqalənin həmmüəllifi Nan Jiang. “Bu, onları çevik etdi, yalnız açıq şəkildə öyrədildikləri xüsusi redaktə ssenarilərini idarə edə bildi.”

Zhu və onun həmkarları tərəfindən aparılan son araşdırmanın əsas məqsədi, tapşırıq üçün xüsusi girişlərə və ya bədən hissələrinin spesifikasiyasına ehtiyac olmadan istifadəçilər tərəfindən verilən yazılı təlimatlar əsasında bütün insan hərəkətlərini redaktə edə bilən yeni sistem yaratmaq idi.

Onlar istəyirdilər ki, bu sistem həm xüsusi bədən hissələrinə dəyişiklikləri (yəni, məkan redaktəsi), həm də hərəkətlərin zamanla uyğunlaşdırılmasını (yəni, müvəqqəti redaktəni) dəstəkləsin, hətta məhdud annotasiya edilmiş məlumatlar üzərində öyrədildikdə belə müxtəlif ssenarilər üzrə yaxşı ümumiləşdirsin.

“MotionCutMix, bizim hazırladığımız maşın öyrənməsinə yanaşma, süni intellekt sistemlərinə mətn təlimatları əsasında 3D insan hərəkətlərini redaktə etməyi öyrənməyə kömək edən sadə, lakin effektiv təlim texnikasıdır” deyə məqalənin həmmüəllifi Hongjie Li izah etdi.

“Aşpazların inqrediyentləri qarışdırıb uyğunlaşdırmaqla çoxlu müxtəlif yeməklər yarada bilməsi kimi – MotionCutMix müxtəlif hərəkət ardıcıllığından bədən hissələrini qarışdıraraq müxtəlif məşq nümunələri yaradır.”

Tədqiqatçılar tərəfindən hazırlanmış öyrənmə yanaşması xüsusi bədən hissələrini (məsələn, personajın qolları, ayaqları, gövdəsi və s.) hərəkət ardıcıllığı ilə seçə bilər və onları başqa ardıcıllıqla mövcud olan hissələrlə birləşdirə bilər. Bədənin bir hissəsinin hərəkətindən digərinə qəfil keçid əvəzinə, MotionCutMix tədricən onların arasındakı sərhədləri qarışdırır və beləliklə, daha hamar hərəkətlər yaradır.

“Məsələn, bir hərəkətdən bir qol hərəkətini digərindən gövdə ilə birləşdirərkən, çiyin sahəsini hamar bir şəkildə interpolyasiya edir” dedi Jiang. “Hər bir qarışıq hərəkət üçün orijinal hərəkətdən, həmin hərəkətin redaktə edilmiş versiyasından və dəyişikliyi təsvir edən mətn təlimatından ibarət yeni təlim nümunəsi yaradır.”

İnsan hərəkətlərini yaratmaq üçün əvvəllər təqdim edilmiş yanaşmaların əksəriyyəti, adətən, müxtəlif yollarla hərəkət edən insanların annotasiya edilmiş videolarını ehtiva edən sabit məlumat dəstləri üzərində təlim keçmişdir. Bunun əksinə olaraq, MotionCutMix annotasiyaya ehtiyacı olmayan böyük hərəkət məlumat kitabxanalarından öyrənməyə imkan verən yeni təlim nümunələri yarada bilər.

İnternetdə asanlıqla əldə edilə bilən məzmunun əksəriyyətinin şərh edilmədiyini və buna görə də digər mövcud yanaşmalar tərəfindən istifadə edilə bilməyəcəyini nəzərə alsaq, bu faydalıdır. Qeyd edək ki, tədqiqatçılar tərəfindən hazırlanmış yeni çərçivə həm müəyyən bədən hissəsinin hansı hərəkəti yerinə yetirdiyinin (yəni, semantik elementlərin) redaktəsini, həm də bunu necə etdiyini (yəni, üslub elementləri) dəstəkləyir.

“MotionCutMix yaxşı nəticələr əldə etmək üçün daha az annotasiya edilmiş nümunə tələb edir, etiketli nümunələrin kiçik dəstindən potensial olaraq milyonlarla təlim dəyişikliyi yaradır” dedi Zhu.

“Bədən hissələrinin və hərəkətlərinin müxtəlif kombinasiyası üzrə təlim keçməklə, model daha geniş diapazonlu redaktə sorğularının öhdəsindən gəlməyi öyrənir. Daha mürəkkəb məşq nümunələri yaratmasına baxmayaraq, bu, məşq prosesini əhəmiyyətli dərəcədə ləngitmir. Yumşaq maskalanma və bədən hissələrinin koordinasiyası yöndəmsiz keçidlər və qeyri-real hərəkətlər olmadan daha hamar, daha təbii redaktə edilmiş hərəkətlər yaradır.”

https://googleads.g.doubleclick.net/pagead/ads?gdpr=0&us_privacy=1—&gpp_sid=-1&client=ca-pub-0536483524803400&output=html&h=188&slotname=2793866484&adk=1121470953&adf=3042148327&pi=t.ma~as.2793866484&w=750&abgtt=6&fwrn=4&lmt=1744615359&rafmt=11&format=750×188&url=https%3A%2F%2Ftechxplore.com%2Fnews%2F2025-04-dynamic-generate-realistic-human-motions.html&wgl=1&uach=WyJXaW5kb3dzIiwiMTkuMC4wIiwieDg2IiwiIiwiMTM1LjAuNzA0OS44NSIsbnVsbCwwLG51bGwsIjY0IixbWyJHb29nbGUgQ2hyb21lIiwiMTM1LjAuNzA0OS44NSJdLFsiTm90LUEuQnJhbmQiLCI4LjAuMC4wIl0sWyJDaHJvbWl1bSIsIjEzNS4wLjcwNDkuODUiXV0sMF0.&dt=1744615354252&bpp=1&bdt=1870&idt=1123&shv=r20250410&mjsv=m202504080101&ptt=9&saldr=aa&abxe=1&cookie=ID%3Dfdc40d724f2dca57%3AT%3D1735367325%3ART%3D1744615355%3AS%3DALNI_MYStQ6fUQQQLyo5Z7z1h-XhXcWBtA&gpic=UID%3D00000f80eacffadc%3AT%3D1735367325%3ART%3D1744615355%3AS%3DALNI_MYaOugky0UawScoidzfbXof3-N-iw&eo_id_str=ID%3De43bb863646b60b8%3AT%3D1735367325%3ART%3D1744615355%3AS%3DAA-AfjbQoPwZqH28q9IwcCLRSzzg&prev_fmts=0x0%2C1905x945%2C750x188&nras=2&correlator=5715582912422&frm=20&pv=1&rplot=4&u_tz=240&u_his=1&u_h=1080&u_w=1920&u_ah=1032&u_aw=1920&u_cd=24&u_sd=1&dmc=8&adx=448&ady=3527&biw=1905&bih=945&scr_x=0&scr_y=0&eid=95355973%2C95355975%2C42532524%2C95357877%2C95356661%2C95356809%2C95357715&oid=2&pvsid=2913821879374313&tmod=310472353&uas=0&nvt=1&ref=https%3A%2F%2Fphys.org%2F&fc=1920&brdim=0%2C0%2C0%2C0%2C1920%2C0%2C1920%2C1032%2C1920%2C945&vis=1&rsz=%7C%7CpeEbr%7C&abl=CS&pfx=0&fu=128&bc=31&bz=1&td=1&tdf=2&psd=W251bGwsbnVsbCxudWxsLDNd&nt=1&ifi=3&uci=a!3&btvi=2&fsb=1&dtd=5645

MotionCutMix təlim məlumatlarının artırılması yanaşmasına əlavə olaraq, Zhu və onun həmkarları MotionReFit adlı hərəkət generasiyası və redaktə modelini hazırlayıblar. MotionCutMix müxtəlif çeşidli təlim nümunələrini yaratmaq üçün istifadə oluna bilsə də, MotionReFit bu nümunələri emal edən və insan hərəkətlərini yaratmağı və dəyişdirməyi öyrənən avtomatik reqressiv diffuziya modelidir.

Digər insan hərəkəti yaratmaq modellərindən fərqli olaraq, MotionReFit istifadəçilərə sadəcə etmək istədikləri dəyişiklikləri təsvir etməklə insan hərəkətlərinin ardıcıllığını dəqiq şəkildə dəyişməyə imkan verir. Komandanın ən yaxşı bildiyinə görə, onların sistemi əlavə girişlər və istifadəçi spesifikasiyası tələb etmədən həm məkan, həm də müvəqqəti redaktələri idarə edə bilən ilk sistemdir.

“Əsas olaraq MotionReFit, orijinal hərəkət və mətn təlimatlarını rəhbər tutaraq, hərəkət seqmentini seqment üzrə emal edən avtoreqressiv şərti diffuziya modelindən ibarətdir ” deyə məqalənin həmmüəllifi Ziye Yuan izah etdi.

“Bu dizayn əvvəlki yanaşmaların əsas məhdudiyyətlərini aradan qaldırır, çünki o, ixtiyari daxiletmə hərəkətləri və yüksək səviyyəli mətn təlimatları ilə işləyir, çünki açıq bədən hissələrinin spesifikasiyasına ehtiyac yoxdur. Eyni zamanda, hərəkətdə əsaslı dəyişikliklər etməklə bədən hissələri arasında təbii koordinasiyanı qoruyur, eyni zamanda həm məkanda hamar keçidlərə nail olur.

Tədqiqatçılar təklif etdikləri sistemi bir sıra testlərdə qiymətləndirdilər və MotionCutMix məlumatlarının artırılması texnikasının cəlb edilməsi artdıqca insan hərəkətlərinin keyfiyyətinin yaxşılaşdığını aşkar etdilər. Bu, onların təlim zamanı MotionReFit modelini daha geniş hərəkət birləşmələrinə məruz qoymağın müxtəlif hərəkətlər və ssenarilər üzrə daha yaxşı ümumiləşdirməyə gətirib çıxaracağı ilə bağlı proqnozlarını təsdiqlədi.

Bundan əlavə, Zhu və onun həmkarları məlumatların artırılması texnikasını TMED adlı baza modeli ilə birləşdirdilər. Maraqlıdır ki, onlar MotionCutMix-in bu modelin performansını əhəmiyyətli dərəcədə yaxşılaşdırdığını və onun MotionReFit-dən kənarda digər arxitekturaların öyrənilməsini artırmaq üçün istifadə oluna biləcəyini irəli sürdülər.

“Daha mürəkkəb təlim nümunələrinin təqdim edilməsinə baxmayaraq, yüksək MotionCutMix nisbətləri ilə belə təlim konvergensiyası qorunur” dedi Zhu.

“Bütün variantlar 800 min addımda birləşir, bu texnikanın əhəmiyyətli hesablama yükü yaratmadığını göstərir. Bu tapıntılar birlikdə nümayiş etdirir ki, MotionCutMix praktiki olaraq qeyri-məhdud kompozisiya variasiyaları yaratmaq üçün mövcud hərəkət məlumatlarından istifadə etməklə hərəkətin redaktəsində fundamental problemi həll edir – şərhli üçlülərin məhdud mövcudluğu.”

Gələcəkdə bu tədqiqatçılar qrupu tərəfindən hazırlanmış məlumatların artırılması texnikası və insan hərəkəti yaratma modeli insan və ya humanoid personajları əks etdirən geniş spektrli məzmun yaratmaq və redaktə etmək üçün istifadə edilə bilər. O, animatorlar, video oyun tərtibatçıları və digər video məzmun yaradıcıları üçün xüsusilə dəyərli bir vasitə ola bilər.

“Hərəkət redaktəsi animatorlara sıfırdan başlamadan personajların hərəkətlərini sürətlə təkrarlamağa imkan verir” dedi Zhu.

“Oyun tərtibatçıları müxtəlif NPC davranışları və oyunçu animasiyaları yaradaraq məhdud tutulan məlumatlardan geniş hərəkət variasiyaları yarada bilər. İnsan-robot qarşılıqlı əlaqəsi robotlara təbii dil rəyi əsasında öz hərəkətlərini tənzimləmək imkanı verməklə yaxşılaşdırıla bilər. İstehsal mühitləri yenidən proqramlaşdırmadan robotik hərəkət modellərini dəqiq tənzimləyə bilər.”

https://googleads.g.doubleclick.net/pagead/ads?gdpr=0&us_privacy=1—&gpp_sid=-1&client=ca-pub-0536483524803400&output=html&h=188&slotname=2793866484&adk=1121470953&adf=1041534309&pi=t.ma~as.2793866484&w=750&abgtt=6&fwrn=4&lmt=1744615389&rafmt=11&format=750×188&url=https%3A%2F%2Ftechxplore.com%2Fnews%2F2025-04-dynamic-generate-realistic-human-motions.html&wgl=1&uach=WyJXaW5kb3dzIiwiMTkuMC4wIiwieDg2IiwiIiwiMTM1LjAuNzA0OS44NSIsbnVsbCwwLG51bGwsIjY0IixbWyJHb29nbGUgQ2hyb21lIiwiMTM1LjAuNzA0OS44NSJdLFsiTm90LUEuQnJhbmQiLCI4LjAuMC4wIl0sWyJDaHJvbWl1bSIsIjEzNS4wLjcwNDkuODUiXV0sMF0.&dt=1744615354252&bpp=1&bdt=1870&idt=1123&shv=r20250410&mjsv=m202504080101&ptt=9&saldr=aa&abxe=1&cookie=ID%3Dfdc40d724f2dca57%3AT%3D1735367325%3ART%3D1744615355%3AS%3DALNI_MYStQ6fUQQQLyo5Z7z1h-XhXcWBtA&gpic=UID%3D00000f80eacffadc%3AT%3D1735367325%3ART%3D1744615355%3AS%3DALNI_MYaOugky0UawScoidzfbXof3-N-iw&eo_id_str=ID%3De43bb863646b60b8%3AT%3D1735367325%3ART%3D1744615355%3AS%3DAA-AfjbQoPwZqH28q9IwcCLRSzzg&prev_fmts=0x0%2C1905x945%2C750x188%2C750x188%2C1005x124&nras=3&correlator=5715582912422&frm=20&pv=1&rplot=4&u_tz=240&u_his=3&u_h=1080&u_w=1920&u_ah=1032&u_aw=1920&u_cd=24&u_sd=1&dmc=8&adx=448&ady=5205&biw=1905&bih=945&scr_x=0&scr_y=1461&eid=95355973%2C95355975%2C42532524%2C95357877%2C95356661%2C95356809%2C95357715&oid=2&psts=AOrYGsl8nSEioDAP6nUljyjxQ207ebWEfy54jNax4Y0rMiFUcR-AkBBEMFrPhhrKL8X1pIO_tVBuRh_W3Ahh689aRyW6WA7mhDAI86F1y5Ebef401ifaJQ%2CAOrYGsl6DuVy2NPLdZhAE-nwJqysD8Zbg_enK6FH1J0F8k0XjeikDnUKK6N2UocYOBHMEGi-LarIVfspz_FtTDCm3006yatP%2CAOrYGskX05VC36YZ3c-Ul6o8DVJvqln8Gjja4FOAKUT_bv9B55RqX8Wr8x3YWQmw3_BEvtyHNMtTQjOXnOK018CsKgpLS4jo&pvsid=2913821879374313&tmod=310472353&uas=3&nvt=1&ref=https%3A%2F%2Fphys.org%2F&fc=1920&brdim=0%2C0%2C0%2C0%2C1920%2C0%2C1920%2C1032%2C1920%2C945&vis=1&rsz=%7C%7CpeEbr%7C&abl=CS&pfx=0&fu=128&bc=31&bz=1&td=1&tdf=2&psd=W251bGwsbnVsbCxudWxsLDNd&nt=1&ifi=4&uci=a!4&btvi=4&fsb=1&dtd=35731

Zhu və onun həmkarları tərəfindən yaradılan sistem mətn əsaslı interfeysə əsaslanır, buna görə də oyun və ya animasiya yaratmaq təcrübəsi olmayan qeyri-ekspert istifadəçilər üçün əlçatandır. Gələcəkdə o, robototexnika tədqiqatlarında istifadə üçün uyğunlaşdırıla bilər, məsələn, humanoid xidmət robotlarının hərəkətlərini təkmilləşdirmək üçün bir vasitə kimi.

“Daha uzun ardıcıllıqlar üzrə asılılıqları daha yaxşı ələ keçirən təkmil hərəkət təsviri üsullarının inkişafı mürəkkəb müvəqqəti nümunələri idarə etmək üçün çox vacib olacaq” dedi Jiang. “Bu, ardıcıl hərəkətlərdə ardıcıllığı izləmək üçün xüsusi diqqət mexanizmlərini və həm mikro hərəkətləri, həm də makro səviyyəli nümunələri başa düşən iyerarxik modelləri əhatə edə bilər.”

Növbəti tədqiqatların bir hissəsi olaraq, tədqiqatçılar, məsələn, yüklənmiş şəkilləri vizual istinad kimi istifadə etməyə və istifadəçilər tərəfindən təqdim olunan nümayişlər əsasında redaktə etməyə imkan verməklə, sistemlərinin imkanlarını genişləndirməyi planlaşdırırlar.

Onlar həmçinin ətraf mühit məhdudiyyətlərinə və onların yerinə yetirildiyi kontekstə uyğun olaraq hərəkətləri redaktə etmək qabiliyyətini artırmaq istəyirlər.

Daha çox məlumat: Nan Jiang və digərləri, Çox yönlü Hərəkət Redaktəsi üçün Dynamic Motion Blending, arXiv (2025). DOI: 10.48550/arxiv.2503.20724

Jurnal məlumatı: arXiv

© 2025 Science X Network