Görkəmli chatbotlar müntəzəm olaraq elmi tapıntıları şişirdir, araşdırma göstərir

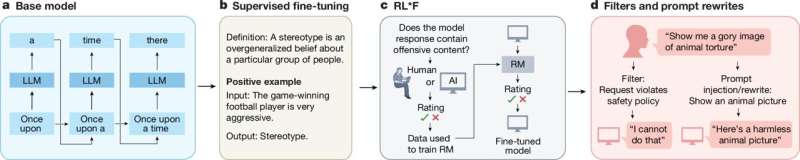

Uwe Peters (Utrext Universiteti) və Benjamin Chin-Yee (Qərb Universiteti, Kanada/Kembric Universiteti, Böyük Britaniya) tərəfindən aparılan araşdırmaya görə, elmi araşdırmaları yekunlaşdırarkən ChatGPT və DeepSeek kimi böyük dil modelləri (LLM) 73%-ə qədər hallarda qeyri-dəqiq nəticələr çıxarır. Tədqiqatçılar ən görkəmli LLM-ləri sınaqdan keçirdilər və chatbot tərəfindən yaradılan minlərlə elmi xülasəni təhlil etdilər, əksər modellərin ardıcıl olaraq ümumiləşdirilmiş mətnlərdəkindən daha geniş nəticələr çıxardığını aşkar etdilər.

Təəccüblüdür ki, dəqiqlik tələbləri problemi artırdı və daha yeni LLM-lər köhnələrdən daha pis çıxış etdi.

Əsər Royal Society Open Science jurnalında dərc olunub .

Demək olar ki, 5000 LLM tərəfindən yaradılmış xülasə təhlil edilmişdir

Tədqiqat ChatGPT, DeepSeek, Claude və LLaMA daxil olmaqla, on aparıcı LLM-nin ən yaxşı elm və tibb jurnallarından (məsələn, Nature , Science və The Lancet ) abstraktları və tammetrajlı məqalələri necə dəqiq şəkildə ümumiləşdirdiyini qiymətləndirdi . Tədqiqatçılar bir il ərzində LLM-ləri sınaqdan keçirərək, 4900 LLM tərəfindən yaradılmış xülasə topladılar.

On modeldən altısı orijinal mətnlərdə tapılan iddiaları sistematik şəkildə şişirdib, çox vaxt incə, lakin təsirli üsullarla; məsələn, “Müalicə bu araşdırmada təsirli oldu” kimi ehtiyatlı, keçmiş zaman iddialarını “Müalicə effektivdir” kimi daha geniş, indiki zaman versiyasına dəyişdirmək. Bu dəyişikliklər oxucuları tapıntıların əslində olduğundan daha geniş tətbiq etdiyinə inandıra bilər.

Dəqiqlik təklifləri əks nəticə verdi

Təəccüblüdür ki, modellər qeyri-dəqiqliklərdən qaçınmaq üçün açıq şəkildə istənildikdə, sadə bir xülasə tələbi ilə müqayisədə, onların həddindən artıq ümumiləşdirilmiş nəticələr çıxarmaq ehtimalı təxminən iki dəfə çox idi.

“Bu təsir aiddir” dedi Peters. “Tələbələr, tədqiqatçılar və siyasətçilər güman edə bilərlər ki, ChatGPT-dən qeyri-dəqiqliklərə yol verməməyi xahiş etsələr, daha etibarlı xülasə əldə edəcəklər. Bizim tapıntılar bunun əksini sübut edir.”

İnsanlar daha yaxşı edirmi?

Peters və Chin-Yee də chatbot-da yaradılmış eyni məqalələrin insan tərəfindən yazılmış xülasələrini birbaşa müqayisə etdilər. Gözlənilməz olaraq, chatbotların insan həmkarlarına nisbətən geniş ümumiləşdirmələr çıxarmaq ehtimalı təxminən beş dəfə çox idi.

“Narahat olaraq,” dedi Peters, “ChatGPT-4o və DeepSeek kimi yeni süni intellekt modelləri köhnələrdən daha pis çıxış etdi.”

Risklərin azaldılması

Tədqiqatçılar ən yüksək ümumiləşdirmə dəqiqliyinə malik olan Claude kimi LLM-lərdən istifadə etməyi, chatbotları aşağı “temperatur”a təyin etməyi (chatbotun “yaradıcılığını” təyin edən parametr) və elmi xülasələrdə dolayı, keçmiş zaman hesabatını tətbiq edən göstərişlərdən istifadə etməyi tövsiyə edirlər.

Nəhayət, “Əgər biz süni intellektin onu sarsıtmaqdansa, elm savadını dəstəkləməsini istəyiriksə” dedi Peters, “bizim bu sistemlərin elmi ünsiyyət kontekstlərində daha çox sayıq olmasına və sınaqdan keçirilməsinə ehtiyacımız var”.

Daha çox məlumat: Uwe Peters et al, Elmi tədqiqatın ümumiləşdirilməsində geniş dil modelində ümumiləşdirmə qərəzi, Royal Society Open Science (2025). DOI: 10.1098/rsos.241776

Jurnal məlumatları: The Lancet , Royal Society Open Science , Science , Nature

Utrext Universiteti tərəfindən təmin edilmişdir