LLM-lərin niyə parolları sındırmaqda yaxşı olmadığına dair yeni fikir

Ingrid Fadelli , Phys.org

Gaby Clark tərəfindən redaktə edilmiş , Robert Eqan tərəfindən nəzərdən keçirilmişdir

Redaktorların qeydləriZülfüqar Kərimov, Unsplash.com.

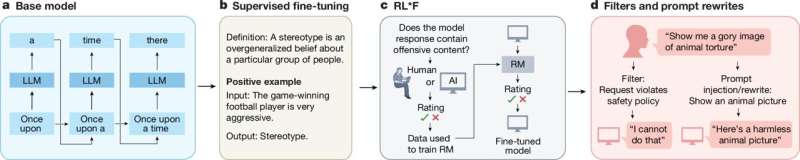

OpenAI-nin ChatGPT danışıq platformasının fəaliyyətini dəstəkləyən model kimi böyük dil modelləri (LLM) müxtəlif dil və kodlaşdırma tapşırıqlarında yaxşı performans göstərdiyini sübut etdi. Bəzi kompüter alimləri bu yaxınlarda bu modellərin zərərli istifadəçilər və hakerlər tərəfindən kiberhücumları planlaşdırmaq və ya insanların şəxsi məlumatlarına daxil olmaq üçün istifadə oluna biləcəyi ehtimalını araşdırırlar.

LLM-lər xüsusi məqsədlər üçün hazırlanmış və istifadəçi tərəfindən müəyyən edilmiş tələblərə cavab verən mətnlər və ya kodlar yarada bilər. Prinsipcə, insanlar haqqında məlumat verildikdə, onlar həmçinin istifadə edə biləcəkləri, onlar üçün mənalı olan adlar və ya tarixlər daxil olmaqla parollar yarada bilər.

Avstraliyadakı Future Data Minds Research Lab-ın tədqiqatçıları bu yaxınlarda bu imkanı araşdıran bir araşdırma apardılar. Onların arXiv preprint serverində dərc edilmiş nəticələri göstərir ki, mövcud LLM-lərin əksəriyyəti xüsusi istifadəçilər üçün etibarlı parollar yarada bilmir, eyni zamanda onların bu tapşırığı niyə zəif yerinə yetirdiyini izah edir.

Mohammad Abdul Rehman, Syed Imad Ali Shah və onların həmkarları öz məqalələrində “Böyük dil modellərinin (LLM) təbii dilin anlaşılmasında və nəsildə diqqətəlayiq imkanları onların kibertəhlükəsizlik proqramları , o cümlədən parolun təxmin edilməsi potensialına marağı artırdı ” dedi.

“Biz sintetik istifadəçi profillərindən istifadə edərək parol sındırmaq üçün əvvəlcədən hazırlanmış LLM-lərin effektivliyinə dair empirik araşdırma apardıq.”

Modellərin inandırıcı parollar yaratmaq qabiliyyətinin qiymətləndirilməsi

Tədqiqatlarını həyata keçirmək üçün tədqiqatçılar əvvəlcə mövcud olmayan istifadəçilər üçün adlarını, ad günlərini və hobbilərini ehtiva edən sintetik (saxta) profillər yaratdılar. Daha sonra üç fərqli LLM-dən bu qondarma istifadəçilərin hər birinin hesablarını qoruyarkən seçə biləcəyi parolların siyahısını yaratmağı xahiş etdilər.

“Biz TinyLLaMA, Falcon-RW-1B və Flan-T5 kimi ən müasir açıq mənbəli LLM-lərin performansını onlara strukturlaşdırılmış istifadəçi atributlarına (məsələn, ad, doğum tarixi, hobbilər) əsaslanan inandırıcı parollar yaratmağa sövq etməklə qiymətləndirdik” deyə müəlliflər yazırlar.

Modellərin tapşırığın yerinə yetirilməsini qiymətləndirmək üçün tədqiqatçılar məlumat axtarışı və parol təxminlərinə diqqət yetirən tədqiqatlarda ümumi istifadə olunan ölçülərdən istifadə ediblər. Hit@1, Hit@5 və Hit@10 adlanan bu ölçülər xüsusi olaraq modelin parolları düzgün təxmin etdiyini və ya düzgün parolları ən inandırıcı kimi sıralamasını xüsusi olaraq ölçür.

Rəhman, Şah və həmkarları yazırdı: “Həm düz mətn, həm də SHA-256 hash müqayisəsi altında Hit@1, Hit@5 və Hit@10 ölçüləri ilə ölçülmüş nəticələrimiz, bütün modellərin Hit@10-da 1,5%-dən az dəqiqliyə nail olmaqla, davamlı olaraq zəif performans nümayiş etdirir”.

“Əksinə olaraq, ənənəvi qaydaya əsaslanan və kombinator əsaslı krekinq üsulları əhəmiyyətli dərəcədə yüksək müvəffəqiyyət nisbətlərini nümayiş etdirir.”

Niyə LLM-lər parol sındırmada pisdir

Tədqiqatçılar tapdılar ki, sınaqdan keçirilmiş üç LLM hər bir istifadəçi profili üçün inandırıcı parollar yarada bilmədi, nadir hallarda düzgün parolu təxmin edirdi. Hal-hazırda qaydalara əsaslanan və kombinator əsaslı üsullar kimi tanınan parolları təxmin etmək üçün istifadə edilən digər hesablama alətləri əhəmiyyətli dərəcədə yaxşı performans göstərdi.

Rehman, Şah və onların həmkarları həmçinin LLM-lərin inandırıcı parollar yaratmaq istənildikdə niyə bu qədər zəif fəaliyyət göstərdiyinə daha çox işıq salmaq məqsədi daşıyan əlavə təhlillər apardılar. Bu təhlillərin nəticələri göstərir ki, bu modellərdə bu tapşırığı yerinə yetirmək üçün zəruri olan bəzi bacarıqlar, məsələn, təlim zamanı rast gəlinən xüsusi nümunələri xatırlamaq və öyrənilmiş parol nümunələrini yeni ssenarilərdə tətbiq etmək bacarığı yoxdur.

“Ətraflı təhlil və vizuallaşdırma vasitəsilə biz parol təxmininin domenə xas tapşırığına tətbiq edildikdə LLM-lərin generativ əsaslandırmasında əsas məhdudiyyətləri müəyyənləşdiririk” deyə müəlliflər yazıblar.

“Bizim tapıntılar göstərir ki, linqvistik şücaətlərinə baxmayaraq, mövcud LLM-lər, xüsusən sızan parol məlumat dəstləri üzərində nəzarət edilən incə tənzimləmə olmadıqda, effektiv parol çıxarmaq üçün tələb olunan domen uyğunlaşması və yadda saxlama imkanlarından məhrumdur.”

Gələcək təhlükəsizlik tədqiqatlarına rəhbərlik edə biləcək fikir

Ümumiyyətlə, bu son araşdırma göstərir ki, LLM-lər hazırda parolların çıxarılması üçün uyğun deyil. Bu tədqiqat qrupu indiyə qədər yalnız üç modeli qiymətləndirdi, lakin gələcək tədqiqatlar digər LLM-lərin ağlabatan parol yaratma imkanlarını da qiymətləndirə bilər.

Rehman, Şah və onların həmkarları yazıb: “Bu tədqiqat rəqib kontekstlərdə LLM-lərin məhdudiyyətləri haqqında tənqidi fikirlər təqdim edir və təhlükəsiz, məxfiliyi qoruyan və möhkəm parol modelləşdirməsində gələcək səylər üçün zəmin yaradır”.

Bu məqalənin müəllifləri tərəfindən toplanan nəticələr tezliklə digər kompüter alimlərini LLM-lərin parol sındırma qabiliyyətlərini araşdırmaq üçün ruhlandıra bilər. Kollektiv olaraq, bu işlər onlayn hesabları daha yaxşı qorumağa kömək edə biləcək, zərərli istifadəçilərin parolları düzgün təxmin etməsinə və həssas məlumatlara daxil olmağa kömək edə biləcək fikirlər toplaya bilər.

Müəllifimiz İnqrid Fadelli tərəfindən sizin üçün yazılmış, Gaby Clark tərəfindən redaktə edilmiş və Robert Eqan tərəfindən yoxlanılmış və nəzərdən keçirilmiş bu məqalə diqqətli insan əməyinin nəticəsidir. Müstəqil elmi jurnalistikanı yaşatmaq üçün sizin kimi oxuculara güvənirik. Bu hesabat sizin üçün əhəmiyyət kəsb edirsə, lütfən, ianə (xüsusilə aylıq) nəzərdən keçirin. Siz təşəkkür olaraq reklamsız hesab əldə edəcəksiniz .

Daha çox məlumat: Mohammad Abdul Rehman et al, Intelligence Fails: An Empirik Study Niyə LLMs Struggle with Password Cracking, arXiv (2025). DOI: 10.48550/arxiv.2510.17884

Jurnal məlumatı: arXiv

© 2025 Science X Network