Süni intellekt chatbotları özlərinə həddən artıq inamlı qalırlar – hətta səhv etdikləri zaman belə, araşdırma tapır

Carnegie Mellon Universiteti tərəfindən

Sadie Harley tərəfindən redaktə edilmişdir , Andrew Zinin tərəfindən nəzərdən keçirilmişdir

Redaktorların qeydləriKredit: Unsplash/CC0 Public Domain

Süni intellektli chatbotlar bu günlərdə smartfon proqramlarından və müştəri xidməti portallarından tutmuş onlayn axtarış sistemlərinə qədər hər yerdə mövcuddur. Bəs bu lazımlı alətlər öz qabiliyyətlərini çox qiymətləndirdikdə nə baş verir?

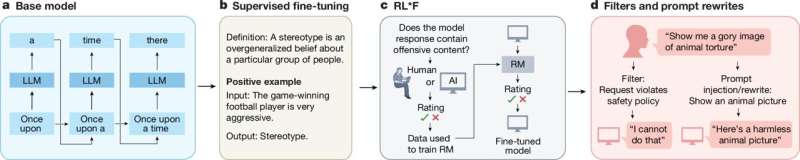

Tədqiqatçılar həm insan iştirakçılardan , həm də dörd böyük dil modelindən (LLM) trivia suallara cavab vermək, NFL oyunlarının və ya Akademiya Mükafatı mərasimlərinin nəticələrini proqnozlaşdırmaq və ya Pictionary-ə bənzər təsviri identifikasiya oyunu oynamaq bacarıqlarına nə qədər əmin olduqlarını soruşdular. Həm insanlar, həm də LLM-lər hipotetik olaraq necə çıxış edəcəklərinə dair həddindən artıq arxayın olmağa meyllidirlər. Maraqlıdır ki, onlar da sualları cavablandırıblar və ya nisbətən oxşar müvəffəqiyyət dərəcələri olan şəkilləri müəyyən ediblər.

Bununla belə, Memory & Cognition jurnalında dərc olunmuş araşdırmaya görə, iştirakçılardan və LLM-lərdən geriyə dönük olaraq nə qədər yaxşı düşündüklərini soruşduqda, yalnız insanlar gözləntiləri tənzimləyə bildi.

“Deyək ki, insanlar bizə 18 sualı düzgün cavablandıracaqlarını söylədilər və onlar 15 sualı düzgün əldə etdilər. Adətən, sonradan onların təxminləri 16 düzgün cavab olacaq ” dedi Trent Cash. Carnegie Mellon Universitetində Sosial Qərar Elmi və Psixologiya şöbələrində. “Beləliklə, onlar hələ də bir az həddindən artıq inamlı olacaqlar, amma o qədər də inamlı deyillər.”

“LLM-lər bunu etməyiblər” dedi tədqiqatın aparıcı müəllifi olan Cash. “Onlar tapşırığın öhdəsindən o qədər də yaxşı gəlmədikdə belə, daha çox inamlı olmağa meyl edirdilər.”

Cash etiraf etdi ki, süni intellekt dünyası hər gün sürətlə dəyişir və bu, onun tətbiqləri haqqında ümumi nəticələr çıxarmağı çətinləşdirir.

Bununla belə, tədqiqatın güclü cəhətlərindən biri məlumatların iki il ərzində toplanması idi ki, bu da ChatGPT, Bard/Gemini, Sonnet və Haiku kimi tanınan LLM-lərin davamlı olaraq yenilənən versiyalarından istifadə etməyi nəzərdə tuturdu. Bu o deməkdir ki, süni intellektə həddən artıq güvən müxtəlif modellərdə zamanla aşkar edilmişdir.

CMU-nun Sosial və Qərar Elmləri Departamentinin professoru və tədqiqatın həmmüəllifi Danny Oppenheimer, “Süni intellekt bir az yalnış görünən bir şey dedikdə, istifadəçilər lazım olduğu qədər şübhə ilə yanaşmaya bilər, çünki süni inam əsassız olsa belə, cavabı inamla təsdiqləyir”.

“İnsanlar zamanla təkamül keçiriblər və doğuşdan bəri başqa insanlar tərəfindən verilən güvən işarələrini şərh etmək üçün məşq ediblər. Əgər qaşlarım çatılırsa və ya cavab verməkdə gecikirəmsə, dediklərimdən mütləq əmin olmadığımı başa düşə bilərsiniz, lakin süni intellektlə onun nə danışdığını bildiyinə dair o qədər də çox ipucumuz yoxdur,” Oppenheimer bildirib.

AI-yə düzgün suallar vermək

LLM-lərin trivia suallara cavab verməkdə və futbol oyununun nəticələrini proqnozlaşdırmaqda dəqiqliyi nisbətən az risk olsa da, tədqiqat bu texnologiyaların gündəlik həyata inteqrasiyası ilə bağlı tələlərə işarə edir.

Məsələn, BBC tərəfindən aparılan bu yaxınlarda aparılan bir araşdırma , LLM-lərə xəbərlə bağlı suallar verildikdə, cavabların yarıdan çoxunda faktiki səhvlər, mənbələrin yanlış təqdim edilməsi və çatışmayan və ya yanlış kontekst daxil olmaqla “əhəmiyyətli məsələlər” olduğunu aşkar etdi. Eynilə, 2023-cü ildə edilən başqa bir araşdırma, hüquqi sorğuların 69-88%-də LLM-lərin “hallüsinasiya edildiyini” və ya yanlış məlumat verdiyini tapdı .

Aydındır ki, süni intellektin nə danışdığını bildiyi sualı heç vaxt bu qədər vacib olmayıb. Və həqiqət budur ki, LLM-lər istifadəçilərin gündəlik olaraq onlara atdığı hər şeyə cavab vermək üçün nəzərdə tutulmayıb.

Oppenheimer, “Əgər mən “Londonun əhalisi nə qədərdir” sualını versəydim, süni intellekt internetdə axtarış aparar, mükəmməl cavab verər və mükəmməl inam kalibrləməsini verərdi” dedi.

Bununla belə, gələcək hadisələr – məsələn, qarşıdan gələn Akademiya Mükafatlarının qalibləri – və ya əllə çəkilmiş şəklin nəzərdə tutulan şəxsiyyəti kimi daha subyektiv mövzular haqqında suallar verməklə tədqiqatçılar chatbotların meta-idrakdakı aşkar zəifliyini, yəni insanın öz düşüncə proseslərindən xəbərdar olmaq qabiliyyətini ifşa edə bildilər.

“Biz hələ də süni intellektin öz inamını necə qiymətləndirdiyini dəqiq bilmirik” dedi Oppenheimer, “amma görünür ki, o, introspeksiya ilə məşğul deyil, ən azı bacarıqla deyil.”

Tədqiqat həmçinin hər bir LLM-nin güclü və zəif tərəflərinə malik olduğunu ortaya qoydu. Ümumiyyətlə, Sonnet kimi tanınan LLM öz həmyaşıdlarına nisbətən daha az inamlı olmağa meyllidir. Eyni şəkildə, ChatGPT-4, Pictionary-ə bənzər sınaqda insan iştirakçıları ilə eyni şəkildə çıxış edərək, 20 əl ilə çəkilmiş təsvirdən 12,5-ni dəqiq müəyyənləşdirdi, Əkizlər isə orta hesabla yalnız 0,93 eskizi müəyyən edə bildi.

Bundan əlavə, Əkizlər orta hesabla 10.03 eskiz düzgün alacağını proqnozlaşdırmışdı və hətta 20 sualdan birindən azına düzgün cavab verdikdən sonra belə, LLM retrospektiv olaraq 14.40-a düzgün cavab verdiyini təxmin etdi və özünü dərk etmədiyini nümayiş etdirdi.

“Əkizlər Pictionary oynamaqda çox pis idi” dedi Cash. “Amma daha pisi, Pictionary-də pis olduğunu bilmirdi. Bu, hovuzda əla olduqlarına and içən, lakin heç vaxt qol vurmayan dosta bənzəyir.”

Süni intellektlə inam yaratmaq

Gündəlik chatbot istifadəçiləri üçün Cash dedi ki, ən böyük qazanc LLM-lərin mahiyyətcə düzgün olmadığını xatırlamaqdır və vacib suallara cavab verərkən onlardan nə qədər əmin olduqlarını soruşmaq yaxşı bir fikir ola bilər.

Əlbəttə ki, tədqiqat göstərir ki, LLM-lər həmişə etimadı dəqiq mühakimə edə bilmirlər, lakin chatbot aşağı inamı qəbul edirsə, bu, onun cavabına etibar edilməməsinin yaxşı əlamətidir.

Tədqiqatçılar qeyd edirlər ki, chatbotların daha böyük məlumat dəstləri üzərində öz bacarıqlarını daha yaxşı başa düşmələri də mümkündür.

Oppenheimer, “Bəlkə də minlərlə və ya milyonlarla sınaq olsaydı, daha yaxşı olardı” dedi.

Nəhayət, həddən artıq güvənmə kimi zəif cəhətləri üzə çıxarmaq yalnız sənayedə LLM-ləri inkişaf etdirən və təkmilləşdirənlərə kömək edəcəkdir. Süni intellekt daha da təkmilləşdikcə, səhvlərindən öyrənmək üçün tələb olunan metakoqnisiyanı inkişaf etdirə bilər.

“Əgər LLM-lər səhv olduqlarını rekursiv şəkildə müəyyən edə bilsələr, bu, bir çox problemləri həll edir” dedi Cash.

“Məncə maraqlıdır ki, LLM-lər çox vaxt öz davranışlarından öyrənə bilmirlər” dedi Cash. “Və bəlkə orada humanist bir hekayə var. Bəlkə də insanların öyrənmələri və ünsiyyət qurma yollarında xüsusi bir şey var.”

Ətraflı məlumat: Qeyri-müəyyənlik-AI-nty-nin kəmiyyətinin müəyyən edilməsi: LLM-lərin Etibar Mühakimələrinin, Yaddaşın və İdrakın Dəqiqliyinin Sınaqlanması (2025). DOI: 10.3758/s13421-025-01755-4

Jurnal məlumatı: Yaddaş və İdrak Carnegie Mellon Universiteti tərəfindən təmin edilmişdir