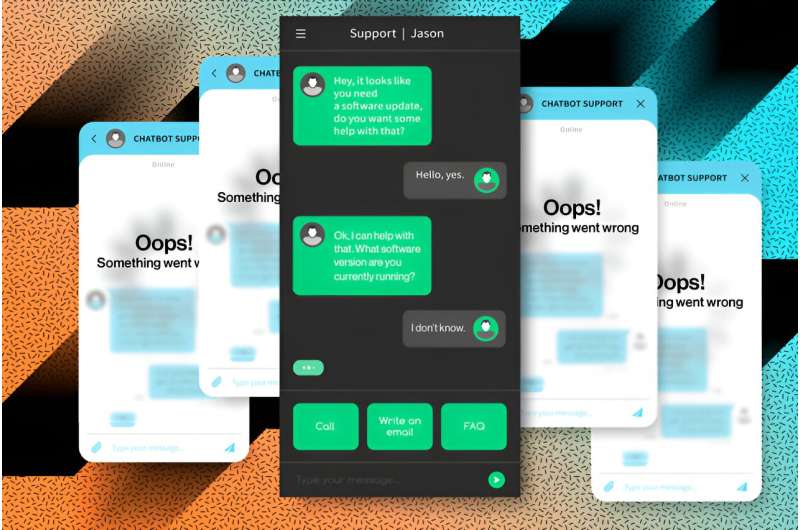

Süni intellekt chatbotlarının bütün günü qəza etmədən söhbət etməsinə imkan verməyin yeni yolu

İnsan-AI söhbəti davamlı dialoqun bir çox dövrünü əhatə etdikdə, ChatGPT kimi chatbotları idarə edən güclü böyük dil maşın öyrənmə modelləri bəzən dağılmağa başlayır və bu, botların performansının sürətlə pisləşməsinə səbəb olur.

MIT və başqa yerlərdən olan tədqiqatçılar qrupu bu problemin təəccüblü səbəbini müəyyən edib və chatbot-a qəza və ya yavaşlama olmadan fasiləsiz söhbəti davam etdirməyə imkan verən sadə həll yolu hazırlayıb.

Onların metodu bir çox böyük dil modellərinin əsasını təşkil edən açar-dəyər keşinə (söhbət yaddaşına bənzəyir) düzəliş daxildir. Bəzi üsullarda, bu keşin tutumundan daha çox məlumat saxlamağa ehtiyac olduqda, ilk məlumat parçaları çıxarılır. Bu, modelin uğursuz olmasına səbəb ola bilər.

Bu ilk bir neçə məlumat nöqtəsinin yaddaşda qalmasını təmin etməklə , tədqiqatçıların metodu söhbətin nə qədər davam etməsindən asılı olmayaraq chatbot-a söhbət etməyə imkan verir.

StreamingLLM adlanan üsul, hətta söhbət 4 milyon sözdən çox uzansa belə, modelin effektiv qalmasına imkan verir. Keçmiş danışıqların bir hissəsini daim yenidən hesablayaraq qəzaya uğramağın qarşısını alan başqa bir üsulla müqayisə edildikdə, StreamingLLM 22 dəfədən çox daha sürətli çıxış etdi.

Bu, chatbot-a iş günü ərzində davamlı olaraq yenidən işə salınmadan uzun söhbətlər aparmağa imkan verə bilər və kopirayter, redaktə və ya kod yaratmaq kimi tapşırıqlar üçün səmərəli AI köməkçilərinə imkan verə bilər.

“İndi bu üsulla biz bu böyük dil modellərini israrla yerləşdirə bilərik. Həmişə söhbət edə biləcəyimiz və son söhbətlərimizə əsasən bizə hər zaman cavab verə biləcək bir chatbot yaratmaqla biz bu chatbotlardan bəzi yeni tətbiqlərdə istifadə edə bilərik . “Elektrik mühəndisliyi və kompüter elmləri (EECS) aspirantı və StreamingLLM – də məqalənin aparıcı müəllifi Guangxuan Xiao deyir .

Xiaonun həmmüəllifləri arasında onun məsləhətçisi, EECS-də dosent, MIT-IBM Watson AI Laboratoriyasının üzvü və NVIDIA-nın görkəmli alimi Song Han; həmçinin Meta AI-də tədqiqatçı alim Yuandong Tian; Beidi Chen, Karnegi Mellon Universitetinin dosenti; və baş müəllif Mayk Lyuis, Meta AI-də tədqiqatçı alim. Əsər mayın 7-11-də Vyanada keçiriləcək Öyrənmə Nümayəndəlikləri üzrə Beynəlxalq Konfransda təqdim olunacaq .

https://googleads.g.doubleclick.net/pagead/ads?gdpr=0&us_privacy=1—&gpp_sid=-1&client=ca-pub-0536483524803400&output=html&h=135&slotname=2793866484&adk=675901022&adf=1873531024&pi=t.ma~as.2793866484&w=540&fwrn=4&lmt=1711224604&rafmt=11&format=540×135&url=https%3A%2F%2Ftechxplore.com%2Fnews%2F2024-02-ai-chatbots-converse-day.html&wgl=1&uach=WyJXaW5kb3dzIiwiMTUuMC4wIiwieDg2IiwiIiwiMTIyLjAuNjI2MS4xMjkiLG51bGwsMCxudWxsLCI2NCIsW1siQ2hyb21pdW0iLCIxMjIuMC42MjYxLjEyOSJdLFsiTm90KEE6QnJhbmQiLCIyNC4wLjAuMCJdLFsiR29vZ2xlIENocm9tZSIsIjEyMi4wLjYyNjEuMTI5Il1dLDBd&dt=1711224554144&bpp=2&bdt=853&idt=203&shv=r20240320&mjsv=m202403200101&ptt=9&saldr=aa&abxe=1&cookie=ID%3Dd8c6cdc5123375cd%3AT%3D1709623025%3ART%3D1711224288%3AS%3DALNI_MY2ynj5TDpMXqOZBx7W90OihbbXuw&gpic=UID%3D00000d6971a748b6%3AT%3D1709623025%3ART%3D1711224288%3AS%3DALNI_MaTILJ6PYHOKRZlSvHcKJ4LkDsnLQ&eo_id_str=ID%3D34d5e14efb6a7c5d%3AT%3D1709623025%3ART%3D1711224288%3AS%3DAA-Afjbw5XrDrmZOIEp3UV8fgvCO&prev_fmts=0x0&nras=1&correlator=7809217037058&frm=20&pv=1&ga_vid=1833901760.1709623018&ga_sid=1711224554&ga_hid=1203941980&ga_fc=1&rplot=4&u_tz=240&u_his=1&u_h=864&u_w=1536&u_ah=816&u_aw=1536&u_cd=24&u_sd=1.25&dmc=8&adx=395&ady=2042&biw=1519&bih=695&scr_x=0&scr_y=0&eid=44759875%2C44759926%2C44759837%2C31082022%2C31082031%2C31082079%2C95322183%2C95326914%2C31078663%2C31078665%2C31078668%2C31078670&oid=2&pvsid=897342381706583&tmod=658211124&uas=0&nvt=3&ref=https%3A%2F%2Ftechxplore.com%2Fpage7.html&fc=1920&brdim=0%2C0%2C0%2C0%2C1536%2C0%2C1536%2C816%2C1536%2C695&vis=1&rsz=%7C%7CpeEbr%7C&abl=CS&pfx=0&fu=128&bc=31&bz=1&td=1&psd=W251bGwsbnVsbCwibGFiZWxfb25seV8xIiwxXQ..&nt=1&ifi=2&uci=a!2&btvi=1&fsb=1&dtd=50705

Çaşqın bir fenomen

Böyük dil modelləri, istifadəçi sorğusundakı sözlər kimi məlumatları token adlanan təsvirlərə kodlayır. Bir çox model yeni mətn yaratmaq üçün bu işarələrdən istifadə edən diqqət mexanizmi kimi tanınandan istifadə edir.

Tipik olaraq, süni intellekt chatbotu indicə gördüyü mətn əsasında yeni mətn yazır, ona görə də sonradan istifadə etmək üçün KV Cache adlanan son nişanları yaddaşda saxlayır. Diqqət mexanizmi keşdəki bütün işarələri özündə cəmləşdirən bir şəbəkə, hər bir işarənin və ya sözün bir-biri ilə nə qədər güclü əlaqədə olduğunu göstərən “diqqət xəritəsi” qurur.

Bu əlaqələri başa düşmək böyük dil modellərinə insana bənzər mətn yaratmağa imkan verən xüsusiyyətlərdən biridir.

Ancaq keş çox böyüdükdə diqqət xəritəsi daha da kütləviləşə bilər ki, bu da hesablamanı ləngidir.

Həmçinin, kodlaşdırma məzmunu keşin saxlaya biləcəyindən daha çox token tələb edərsə, modelin performansı aşağı düşür. Məsələn, bir məşhur model 4,096 token saxlaya bilər, lakin akademik məqalədə təxminən 10,000 token var.

Bu problemlərin öhdəsindən gəlmək üçün tədqiqatçılar yeni tokenlər əlavə etmək üçün ən köhnə tokenləri çıxaran “sürüşmə önbelleği”ndən istifadə edirlər. Bununla belə, ilk işarə çıxarılan kimi modelin performansı tez-tez aşağı düşür və yeni yaradılan sözlərin keyfiyyətini sürətlə aşağı salır.

Bu yeni məqalədə tədqiqatçılar anladılar ki, ilk işarəni sürüşmə keşində saxlasalar, keş ölçüsü aşıldığında belə model öz performansını qoruyacaq.

Amma bunun heç bir mənası yox idi. Romandakı ilk sözün son sözlə heç bir əlaqəsi yoxdur, bəs niyə modelin ən yeni sözü yaratmaq üçün ilk söz bu qədər vacib olsun?

Tədqiqatçılar yeni məqalələrində bu fenomenin səbəbini də açıblar.

Diqqət batır

Bəzi modellər diqqət mexanizmində Softmax əməliyyatından istifadə edir ki, bu da hər bir tokenə onun bir-biri ilə nə dərəcədə əlaqəli olduğunu göstərən bir xal təyin edir. Softmax əməliyyatı bütün diqqət xallarının 1-ə qədər cəmlənməsini tələb edir. Əksər tokenlər güclü əlaqəli olmadığı üçün onların diqqət xalları çox aşağıdır. Model ilk işarədə qalan diqqət xalını silir.

Tədqiqatçılar bu ilk əlaməti “diqqət udmaq” adlandırırlar.

“Bizə diqqət yuvasına ehtiyacımız var və model qlobal miqyasda göründüyü üçün ilk işarəni diqqət mərkəzi kimi istifadə etmək qərarına gəldi – hər bir digər token onu görə bilər. Biz tapdıq ki, modeli saxlamaq üçün diqqət yuvasını həmişə ön yaddaşda saxlamalıyıq. dinamika,” Han deyir.

StreamingLLM-i qurarkən tədqiqatçılar kəşf etdilər ki, sürüşmə önbelleğinin əvvəlində dörd diqqət ayırma işarəsinin olması optimal performansa gətirib çıxarır.

Onlar həmçinin tapdılar ki, hər bir tokenin mövqe kodlaşdırması eyni qalmalıdır, hətta yeni tokenlər əlavə olunsa və digərləri sökülsə belə. Token 5 sönürsə, token 6 indi keşdə beşinci işarə olsa da, 6 olaraq kodlanmış qalmalıdır.

Bu iki ideyanı birləşdirərək, onlar StreamingLLM-ə təkrar hesablamadan istifadə edən məşhur metoddan üstün olmaqla davamlı söhbəti davam etdirməyə imkan verdilər.

Məsələn, keşdə 256 token olduqda, yenidən hesablama metodu yeni nişanı deşifrə etmək üçün 63 millisaniyə, StreamingLLM isə 31 millisaniyə çəkir. Bununla belə, əgər keş ölçüsü 4096 tokenə qədər böyüyərsə, yenidən hesablama yeni token üçün 1411 millisaniyə, StreamingLLM isə cəmi 65 millisaniyə tələb edir.

https://googleads.g.doubleclick.net/pagead/ads?gdpr=0&us_privacy=1—&gpp_sid=-1&client=ca-pub-0536483524803400&output=html&h=135&slotname=2793866484&adk=675901022&adf=1897700409&pi=t.ma~as.2793866484&w=540&fwrn=4&lmt=1711224647&rafmt=11&format=540×135&url=https%3A%2F%2Ftechxplore.com%2Fnews%2F2024-02-ai-chatbots-converse-day.html&wgl=1&uach=WyJXaW5kb3dzIiwiMTUuMC4wIiwieDg2IiwiIiwiMTIyLjAuNjI2MS4xMjkiLG51bGwsMCxudWxsLCI2NCIsW1siQ2hyb21pdW0iLCIxMjIuMC42MjYxLjEyOSJdLFsiTm90KEE6QnJhbmQiLCIyNC4wLjAuMCJdLFsiR29vZ2xlIENocm9tZSIsIjEyMi4wLjYyNjEuMTI5Il1dLDBd&dt=1711224554146&bpp=2&bdt=855&idt=213&shv=r20240320&mjsv=m202403200101&ptt=9&saldr=aa&abxe=1&cookie=ID%3Dd8c6cdc5123375cd%3AT%3D1709623025%3ART%3D1711224604%3AS%3DALNI_MY2ynj5TDpMXqOZBx7W90OihbbXuw&gpic=UID%3D00000d6971a748b6%3AT%3D1709623025%3ART%3D1711224604%3AS%3DALNI_MaTILJ6PYHOKRZlSvHcKJ4LkDsnLQ&eo_id_str=ID%3D34d5e14efb6a7c5d%3AT%3D1709623025%3ART%3D1711224604%3AS%3DAA-Afjbw5XrDrmZOIEp3UV8fgvCO&prev_fmts=0x0%2C540x135%2C1005x124&nras=2&correlator=7809217037058&frm=20&pv=1&ga_vid=1833901760.1709623018&ga_sid=1711224554&ga_hid=1203941980&ga_fc=1&rplot=4&u_tz=240&u_his=1&u_h=864&u_w=1536&u_ah=816&u_aw=1536&u_cd=24&u_sd=1.25&dmc=8&adx=395&ady=4121&biw=1519&bih=695&scr_x=0&scr_y=1389&eid=44759875%2C44759926%2C44759837%2C31082022%2C31082031%2C31082079%2C95322183%2C95326914%2C31078663%2C31078665%2C31078668%2C31078670&oid=2&psts=AOrYGsmund-CkzjZwHi3Jfg6b8Nb7xBWxpk_xIxXkM0PNJd-M1Vqkv9SMbHhVKHHiSz5C0_JptUb2u7kBLaF4jo21ecRRfosqlmt_0tKew8dAgJowawkhg%2CAOrYGsmJnQ0sYNuKTSL2qZQ64Ptz3bbJayntTxhLvpdNzcnhZmL1bvmi4ejNcPWRphminyjRfVxlVH8PSa82Mz3YOgdp2g&pvsid=897342381706583&tmod=658211124&uas=3&nvt=3&ref=https%3A%2F%2Ftechxplore.com%2Fpage7.html&fc=1920&brdim=0%2C0%2C0%2C0%2C1536%2C0%2C1536%2C816%2C1536%2C695&vis=1&rsz=%7C%7CpeEbr%7C&abl=CS&pfx=0&fu=128&bc=31&bz=1&td=1&psd=W251bGwsbnVsbCwibGFiZWxfb25seV8xIiwxXQ..&nt=1&ifi=3&uci=a!3&btvi=3&fsb=1&dtd=93832

“Diqqəti azaltma mexanizmi ətrafında cəmlənmiş StreamingLLM-in innovativ yanaşması hətta 4 milyona qədər uzunluqdakı mətnləri emal edərkən belə sabit yaddaş istifadəsini və performansını təmin edir” dedi ABŞ Milli Universitetinin kompüter elmləri üzrə gənc professoru Yang You. Bu işlə məşğul olmayan Sinqapur.

“Bu imkan sadəcə təsir edici deyil; o, dəyişdiricidir və StreamingLLM-in geniş süni intellekt tətbiqetmələrində tətbiq edilməsinə imkan verir. StreamingLLM-in performansı və çox yönlü olması onu süni intellektə əsaslanan nəsil tətbiqetmələrinə yanaşma tərzimizdə inqilab etməyə hazır olan yüksək perspektivli texnologiya kimi qeyd edir. “

Karnegi Mellon Universitetinin maşın öyrənməsi və kompüter elmləri kafedrasının dosenti Tianqi Chen də bu tədqiqatla məşğul olmayan, razılaşdı və dedi: “Streaming LLM böyük dil modellərinin danışıq uzunluğunu rahat şəkildə uzatmağa imkan verir. Biz istifadə edirik. Bu, Mistral modellərinin iPhone-larda böyük müvəffəqiyyətlə yerləşdirilməsinə imkan yaratmaqdır.”

Tədqiqatçılar, həmçinin, bütün təlim nümunələrində bir neçə yer tutucu işarəni önə çəkməklə, model təlimi zamanı diqqət yuvalarının istifadəsini araşdırdılar.

Onlar tapdılar ki, diqqət yuvaları ilə məşq bir modelə əvvəlcədən hazırlanmış modelin performansını sabitləşdirmək üçün adətən tələb olunan dörd deyil, öz yaddaşında yalnız bir diqqət yuvası ilə performansını saxlamağa imkan verir.

StreamingLLM modeli davamlı söhbət aparmağa imkan versə də, model keşdə saxlanmayan sözləri xatırlaya bilmir . Gələcəkdə tədqiqatçılar çıxarılan tokenləri əldə etmək və ya modelə əvvəlki söhbətləri yadda saxlamağa imkan verən üsulları araşdıraraq bu məhdudiyyəti hədəf almağı planlaşdırırlar.

Ətraflı məlumat: Guangxuan Xiao et al, Diqqət Sinks ilə Efficient Streaming Language Models, arXiv (2023). DOI: 10.48550/arxiv.2309.17453Massaçusets Texnologiya İnstitutu tərəfindən təmin edilmişdir