Süni intellekt həqiqəti uydurmadan ayırmağı çətinləşdirir

Taylor Swift onlarla musiqi mükafatından tutmuş bir neçə dünya rekorduna qədər çoxlu xəbər dəyərli nailiyyətlərə malikdir. Ancaq keçən yanvar ayında meqa-ulduz daha pis və tamamilə onun nəzarətindən kənar bir şey üçün başlıq etdi. O, onlayn zorakılığın hədəfi olub.

Kimsə Swift-in saxta çılpaq şəkillərini yaratmaq üçün süni intellektdən və ya süni intellektdən istifadə edib . Bu görüntülər sosial şəbəkələri bürüdü. Onun pərəstişkarları #ProtectTaylorSwift-ə zəng edərək tez cavab verdilər. Ancaq bir çox insan hələ də saxta şəkilləri görüb.

Bu hücum qeyri-mütəxəssislərin süni intellektlə asanlıqla edə bildiyi audio və vizuallar da daxil olmaqla, geniş saxta medianın yalnız bir nümunəsidir. Belə iyrənc hücumların qurbanı təkcə məşhurlar deyil. Məsələn, keçən il kişi sinif yoldaşları Nyu-Cersi liseyində qızların saxta seksual şəkillərini yayıblar.

Bu Məqalə üçün Sinif Resursları

Bu məqalə üçün pulsuz pedaqoq resursları mövcuddur. Giriş üçün qeydiyyatdan keçin:E-poçt ünvanı*Get

Artıq Qeydiyyatdan Keçmisiniz?Yuxarıda e-poçt ünvanınızı daxil edin.

Süni intellektlə hazırlanmış şəkillər, audio kliplər və ya real insanlarınki kimi maskalanan videolar deepfakes kimi tanınır. Bu tip məzmun siyasətçilərin ağzına söz salmaq üçün istifadə olunub. Yanvar ayında robot zənglər prezident Co Baydenin səsinin dərin saxta qeydini göndərdi . O, insanlardan Nyu-Hempşirin ilkin seçkilərində səs verməməyi xahiş edib. Moldova prezidenti Maia Sandu-nun ötən ilin dekabrında çəkdiyi saxta video rusiyayönlü siyasi partiya liderini dəstəkləyirdi.

Süni intellekt həm də elm və sağlamlıq haqqında yalan məlumatlar çıxarıb. 2023-cü ilin sonlarında külək enerjisi ilə mübarizə aparan Avstraliya qrupu, yeni təklif edilən külək turbinlərinin ildə 400 balinanı öldürə biləcəyini göstərən araşdırmalar olduğunu iddia etdi. Onlar Marine Policy -də dərc edilmiş bir araşdırmaya işarə etdilər . Lakin həmin jurnalın redaktoru araşdırmanın mövcud olmadığını söylədi . Görünür, kimsə süni intellektdən istifadə edərək, jurnaldan yanlış görünən saxta məqaləni ələ salıb.

Bir çox insan süni intellektdən yalan danışmaq üçün istifadə edib. Lakin süni intellekt təsadüfən yanlış məlumat verə bilər. Bir tədqiqat qrupu beş AI modelinə səsvermə ilə bağlı suallar verdi. Modellər tez-tez səhv və yanıltıcı cavablar yazdılar , komanda AI Demokratiya Layihələri üçün 2023-cü il hesabatında paylaşdı.

Qeyri-dəqiq məlumat (yanlış məlumat) və açıq yalanlar (dezinformasiya) illərdir mövcuddur. Lakin süni intellekt etibarsız iddiaları yaymağı asanlaşdırır, daha sürətli və ucuzlaşdırır. Süni intellekt tərəfindən yaradılan saxtakarlığı aşkar etmək və ya məhdudlaşdırmaq üçün bəzi vasitələr olsa da , ekspertlər bu səylərin silahlanma yarışına çevriləcəyindən narahatdırlar. Süni intellekt alətləri getdikcə daha yaxşı olacaq və saxta xəbərləri dayandırmağa çalışan qruplar ayaqlaşmaq üçün mübarizə aparacaqlar.

Bahislər yüksəkdir. İnternetdə ortaya çıxan daha inandırıcı saxta sənədlərlə kimə və nəyə etibar edəcəyinizi bilmək çətindir.

https://www.youtube.com/embed/HK6y8DAPN_0?feature=oembed&enablejsapi=1&origin=https:%2F%2Fwww.snexplores.orgBu video kliplər kolleksiyası süni intellektdən istifadə etməklə, sadəcə hadisənin təsvirini yazmaqla nələrin hazırlana biləcəyini göstərir – hətta mətbəx stəkanında kobud qəhvə dənizlərini idarə edən pirat gəmiləri kimi xəyali olanları. OpenAI bu demo filmi Sora mətndən videoya modelinin buraxılmasından əvvəl yayımladı.

Saxtaları çıxarmaq

Həqiqi saxta fotolar, xəbərlər və digər məzmunlar hazırlamaq çox vaxt və bacarıq tələb edirdi. Bu xüsusilə deepfake audio və video kliplər üçün doğru idi. Lakin süni intellekt yalnız son bir ildə çox yol qət edib. İndi demək olar ki, hər kəs mətnlər, şəkillər, audio və ya videolar hazırlamaq üçün generativ süni intellektdən istifadə edə bilər – bəzən bir neçə dəqiqə ərzində.

Bir qrup səhiyyə tədqiqatçısı bu yaxınlarda bunun nə qədər asan olduğunu göstərdi. OpenAI-nin Playground platformasındakı alətlərdən istifadə edərək, iki komanda üzvü təxminən bir saat ərzində 102 bloq məqaləsi hazırlayıb. Parçalarda peyvəndlər və vapinqlər haqqında 17.000-dən çox inandırıcı yalan məlumat var idi.

Ashley Hopkins deyir: “Bizim dezinformasiyanı necə asanlıqla yarada biləcəyimizi kəşf etmək təəccüblü idi”. O, Avstraliyanın Adelaida şəhərindəki Flinders Universitetində klinik epidemioloqdur – və ya xəstəlik detektividir. O və həmkarları bu tapıntıları keçən noyabr ayında JAMA Internal Medicine -də paylaşdılar .

İnsanların süni intellekt məzmununun yaradılmasına da nəzarət etməsinə ehtiyac yoxdur. Veb saytlar çox az və ya heç bir nəzarət olmadan yalan və ya aldadıcı “xəbər” hekayələrini yayımlaya bilər. McKenzie Sadeghi deyir ki, bu saytların çoxu sizə onların arxasında kimin dayandığı barədə az məlumat verir. O, Vaşinqtondakı NewsGuard-da süni intellekt və xarici təsirlərə diqqət yetirən redaktordur

2023-cü ilin may ayına qədər Sadeqinin qrupu 49 belə sayt müəyyən etmişdi. Bir ildən az müddətdə bu rəqəm 750-dən çox artdı. Çoxlarının Gündəlik Saat Yeniləməsi və ya iBusiness Day kimi xəbər səslənən adları var. Amma onların “xəbərləri” uydurma hadisələr ola bilər.

Saxta xəbər (həqiqətən)

Bu qrafik NewsGuard-ın süni intellekt tərəfindən yaradılan etibarsız xəbərlər hazırlayan neçə vebsayt tapdığını göstərir. Bu rəqəm 2023-cü ilin may ayında 49 saytdan dekabr ayına qədər 600-dən çox oldu. 2024-cü ilin mart ayına qədər NewsGuard-ın Reallıq Yoxlaması 750-dən çox tapdı.

Generativ AI modelləri müxtəlif yollarla real görünən saxtakarlıqlar istehsal edir. Mətn yazma modelləri ümumiyyətlə hansı sözlərin başqalarını izləyəcəyini proqnozlaşdırmaq üçün nəzərdə tutulmuşdur, Zain Sarvar izah edir. O, İllinoys ştatındakı Çikaqo Universitetində kompüter elmləri üzrə təhsil alan aspirantdır. Süni intellekt modelləri böyük həcmdə mövcud mətndən istifadə edərək bunu necə etməyi öyrənirlər.

Təlim zamanı süni intellekt hansı sözlərin başqalarını izləyəcəyini təxmin etməyə çalışır. Sonra seçdiyi sözlərin doğru olub-olmaması ilə bağlı rəy alır. Sərvar deyir ki, bu yolla süni intellekt qrammatika, söz seçimi və daha çox şeylə bağlı mürəkkəb qaydalara əməl etməyi öyrənir. Bu qaydalar insanlar tələb etdikdə modelə yeni material yazmağa kömək edir.

Şəkilləri müxtəlif üsullarla işləyən AI modelləri. Bəziləri bir növ generativ rəqib şəbəkə və ya GAN istifadə edir. Şəbəkə iki sistemdən ibarətdir: generator və detektiv. Generatorun vəzifəsi daha yaxşı və daha real görüntülər yaratmaqdır. Detektiv daha sonra bu saxta şəkillərdə nəyinsə səhv olduğunu göstərən əlamətlər axtarır.

“Bu iki model bir-biri ilə vuruşmağa çalışır” dedi Sarvar. Ancaq nə vaxtsa generatordan gələn görüntü detektivi aldadacaq. İnanılmaz dərəcədə real görüntü modelin çıxışına çevrilir.

AI şəkilləri yaratmağın başqa bir ümumi yolu diffuziya modelidir. “Bu, irəli və geriyə doğru bir prosedurdur” dedi Sarvar. Təlimin birinci hissəsi bir şəkil çəkir və təsadüfi səs-küy və ya müdaxilə əlavə edir. Pis qəbulu olan köhnə televizorlarda qeyri-səlis piksellər haqqında düşünün, deyir. Model daha sonra təsadüfi səs-küy təbəqələrini təkrar-təkrar aradan qaldırır. Nəhayət, orijinala yaxın aydın bir görüntü əldə edir. Təlim bu prosesi çoxlu şəkillərlə dəfələrlə edir. Model daha sonra öyrəndiklərini istifadəçilər üçün yeni şəkillər yaratmaq üçün istifadə edə bilər.

real nədir? Saxta nədir?

Süni intellekt modelləri öz işlərində o qədər yaxşı olublar ki, bir çox insanlar yaradılmış məzmunun saxta olduğunu başa düşməyəcəklər.

Todd Helmus deyir ki, süni intellektlə hazırlanmış məzmun “insanların yaratdığından daha yaxşıdır”. O, Vaşinqtondakı RAND Korporasiyasında davranış üzrə alimdir, “Sadə və sadədir, real görünür.”

Doğrudur yoxsa Yalan?

Bir araşdırmada iştirak edənlər süni intellekt (“sintetik”) tərəfindən hazırlanan həm doğru, həm də yalan yazıları həqiqi insanlar tərəfindən (“üzvi”) edilənlərdən daha dəqiq olaraq qiymətləndirdilər.

Yaşıl çubuqlar həqiqi tvitləri təmsil edir. Qırmızı çubuqlar yanlış yazıları təmsil edir. Dezinformasiyanın tanınması balı, yazıları doğru və ya yanlış olaraq düzgün qiymətləndirən insanların payıdır.

Bir araşdırmada insanlar tvitlərin (indi X yazıları) süni intellekt modelindən, yoxsa həqiqi insanlardan gəldiyini mühakimə etməyə çalışdılar. İnsanlar süni intellekt modellərinin yalan yazılarına insanlar tərəfindən yazılmış yalan yazılardan daha çox inanırdılar. İnsanlar həmçinin süni intellekt modellərinin həqiqi yazılarına insanlar tərəfindən yazılmış həqiqi yazılardan daha çox inanırdılar.

Federico Germani və həmkarları bu nəticələri keçən iyun ayında Science Advances jurnalında paylaşdılar. Germani İsveçrənin Sürix Universitetində dezinformasiya üzrə təhsil alır. “Hazırda əlimizdə olan süni intellekt modelləri, həqiqətən, insan dilini təqlid etməkdə çox yaxşıdır” deyir.

Üstəlik, AI modelləri də insanlar kimi emosional dillə yaza bilir. “Beləliklə, onlar məlumatları və mətni insanları manipulyasiya etməkdə daha yaxşı bir şəkildə qururlar” deyir Germani.

İnsanlar da saxta görüntüləri realdan ayırmaqda çətinlik çəkirlər. Vision Research -də 2022-ci ildə aparılan bir araşdırma göstərdi ki, insanlar 2019-cu ilin əvvəlindən etibarən real üzlərin şəkilləri ilə GAN modeli ilə çəkilmiş üzlər arasında fərqi ayıra bilirlər. Lakin iştirakçılar təxminən bir il sonra daha inkişaf etmiş süni intellekt tərəfindən hazırlanmış real saxta üzləri aşkar etməkdə çətinlik çəkdilər. Əslində insanların sonrakı qiymətləndirmələri təxminlərdən üstün olmadı.

Michoel Moshel deyir ki, bu, insanların “tez-tez real süni üzlərin həqiqi üzlərdən daha orijinal olduğunu qəbul etdiyinə” işarə edir. O əlavə edir ki, daha yeni modellər “bizim tədqiqatımızda istifadə etdiyimizdən daha real görüntülər yarada bilər”. O, Avstraliyanın Sidney şəhərindəki Macquarie Universitetində tədqiqat üzərində işləyən aspirantdır. O, düşünmə və öyrənmədə rol oynayan beyin faktorlarını öyrənir.

Moşelin komandası insanlar təcrübə üçün şəkillərə baxarkən beyin fəaliyyətini müşahidə ediblər. İnsanlar süni intellektlə hazırlanmış sifətlə real sifətin şəklinə baxanda bu fəaliyyət fərqlənirdi. Lakin fərqlər hər bir AI modeli üçün eyni deyildi. Bunun səbəbini tapmaq üçün daha çox araşdırmaya ehtiyac var.

Tərbiyəçilər və Valideynlər, Fırıldaq Vərəqinə Qeydiyyatdan Keçin

Tədris mühitində Science News Explores istifadə etməyinizə kömək edəcək həftəlik yeniləmələrE-poçt ünvanı*Get

Artıq nəyin doğru olduğunu necə bilə bilərik?

Əvvəllər foto və videolar hansısa hadisənin baş verdiyini sübut edirdi. Ancaq süni intellekt dərin saxtakarlığı ilə bu, artıq doğru deyil.

“Düşünürəm ki, gənc nəsil sadəcə bir fotoşəkilə güvənməməyi öyrənəcək” dedi Karl Vondrik. Nyu Yorkdakı Kolumbiya Universitetində kompüter alimidir. O, orada 27 fevral proqramında süni intellekt məzmununun artan selindən danışdı.

Bu inamsızlıq siyasətçilərə və başqalarına bir şeyin baş verdiyini inkar etmək üçün qapı açır – hətta saxta olmayan video və ya audio onun baş verdiyini göstərsə belə. Məsələn, 2023-cü ilin sonlarında ABŞ prezidentliyinə namizəd Donald Tramp iddia etdi ki, siyasi düşmənlər onu zəif göstərmiş reklamda süni intellektdən istifadə ediblər. Əslində, Forbes xəbər verir ki , reklam həqiqətən baş verən səhvləri göstərirdi. Tramp həqiqəti demədi.

https://www.youtube.com/embed/IOyrbsNcXt8?feature=oembed&enablejsapi=1&origin=https:%2F%2Fwww.snexplores.orgBu seqment CBC Kids News-dandır. Bu, süni intellektdən istifadə edilməklə hazırlanmış dərin saxta video və səs yazılarına aldanmağın nə qədər asan olduğunu göstərir. O, həmçinin dərin saxtakarlığın nə olduğunu və tənqidi düşüncənin onlara aldanmamağınıza necə kömək edə biləcəyini izah edir.

Deepfakes daha çox yayıldıqca, mütəxəssislər yalançının dividentindən narahat olurlar . Alondra Nelson deyir: “Bu dividend ondan ibarətdir ki, heç bir məlumat etibarlı olmur – [deməli] insanlar heç nəyə inanmırlar”. O, Princeton, NJ-də Təkmilləşdirmə İnstitutunda sosioloqdur

Yalançının dividendləri dövlət məmurlarını və ya başqalarını dediklərinə və ya etdiklərinə görə məsuliyyətə cəlb etməyi çətinləşdirir. “Bunun üstünə hər şeyin aldatma ola biləcəyinə dair kifayət qədər sabit bir duyğu əlavə edin” dedi Nelson. Bu, “fərdlər, cəmiyyətlər və cəmiyyətlər olaraq aramızda ehtiyac duyduğumuz əlaqələri həqiqətən pozmaq üçün bir reseptdir.”

İnamın olmaması cəmiyyətin paylaşılan reallıq hissini sarsıdacaq, Ruth Mayo izah edir. O, İsraildəki Yerusəlim İvrit Universitetində psixoloqdur. Onun işi insanların sosial şəraitdə necə düşündüyünə və düşünməsinə yönəlib. “Etibarsız düşüncədə olduğumuz zaman,” o deyir, “sadəcə heç nəyə inanmırıq – hətta həqiqətə də.” Bu, insanların seçkilər, sağlamlıq, xarici siyasət və s. haqqında yaxşı məlumatlı qərarlar qəbul etmək qabiliyyətinə zərər verə bilər.

Silah yarışı

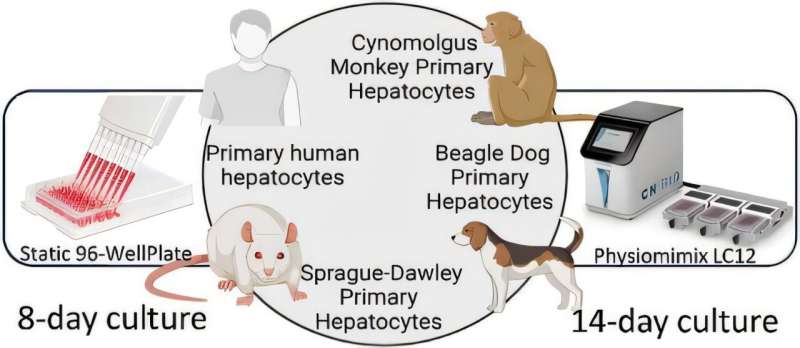

Bəzi AI modelləri saxta xəbərlər, fotoşəkillər və videolar yaratmamaq üçün qoruyucularla qurulmuşdur . Modelə daxil edilmiş qaydalar ona müəyyən tapşırıqları yerinə yetirməməyi söyləyə bilər. Məsələn, kimsə modeldən dövlət qurumundan gəldiyini iddia edən bildirişləri silməyi xahiş edə bilər. Bundan sonra model istifadəçiyə bunu etməyəcəyini söyləməlidir.

Bu yaxınlarda apardıqları araşdırmada Germani və həmkarları müəyyən ediblər ki, nəzakətli dildən istifadə bəzi modellərin dezinformasiyanı nə qədər tez buraxmasını sürətləndirə bilər . Həmin modellər təlim zamanı insandan insana qarşılıqlı əlaqədən istifadə edərək insanlara necə cavab verməyi öyrəniblər. Başqaları nəzakətli olduqda insanlar daha çox müsbət cavab verirlər. Buna görə də çox güman ki, “model sadəcə öyrəndi ki, statistik olaraq bu şəkildə işləməlidir”, Germani deyir. Səhv edənlər dezinformasiya yaratmaq üçün modeli manipulyasiya etmək üçün bundan istifadə edə bilər.

Tədqiqatçılar AI saxtakarlığını aşkar etməyin yolları üzərində işləyirlər. Hələ ki, heç bir əmin düzəliş yoxdur.

Sərvar süni intellekt aşkarlayan bir neçə aləti sınaqdan keçirən komandanın üzvü idi. Hər bir alət ümumiyyətlə süni intellektlə hazırlanmış mətnləri aşkar etməkdə yaxşı iş gördü – əgər bu mətnlər alətin təlimdə gördüklərinə bənzəyirdisə. Tədqiqatçılar onlara digər süni intellekt modelləri ilə hazırlanmış mətnləri göstərdikdə alətlər yaxşı nəticə vermədi . Problem ondadır ki, hər hansı aşkarlama aləti üçün “onu bütün mümkün mətnlər üzrə öyrədə bilməzsiniz” deyə Sarvar izah edir.

Elmi sualınız var? Biz kömək edə bilərik!

Sualınızı burada təqdim edin və biz ona Science News Explores jurnalının qarşıdan gələn sayında cavab verə bilərik

Bir süni intellekt aşkarlama vasitəsi digərlərindən daha yaxşı işləyirdi. Digər proqramların istifadə etdiyi əsas addımlarla yanaşı, bu, mətndəki xüsusi isimləri təhlil etdi. Xüsusi isimlər konkret insanların, yerlərin və əşyaların adını çəkən sözlərdir. Sərvər deyir ki, süni intellekt modelləri bəzən bu sözləri yazılarında qarışdırırlar və bu, alətin saxtakarlığı daha yaxşı öyrənməsinə kömək etdi. Onun komandası keçən il IEEE konfransında bu barədə öz nəticələrini bölüşdü.

Sürix Universitetində Germani bildirib ki, bu müdafiələrdən keçməyin yolları var.

Rəqəmsal “su nişanları” da AI tərəfindən hazırlanmış mediaya qarşı reallığı yoxlamağa kömək edə bilər. Bəzi müəssisələr artıq öz şəkillərini və ya digər materiallarını etiketləmək üçün loqolardan və ya kölgələrdən istifadə edirlər. AI modelləri eyni şəkildə çıxışlarına etiketlər daxil edə bilər. Bu, açıq bir işarə ola bilər. Və ya mətn və ya şəkil üçün kompüter kodunda incə bir qeyd və ya nümunə ola bilər. Bu etiket, AI-nin bu faylları hazırladığına dair bir məlumat olardı.

Praktikada bu o deməkdir ki, çoxlu sayda su nişanı ola bilər. Bəzi insanlar süni intellekt təsvirlərindən onları silməyin yollarını tapa bilər. Digərləri saxta AI su nişanlarını real məzmuna yerləşdirməyin yollarını tapa bilər. Yaxud insanlar su nişanlarına ümumiyyətlə məhəl qoymurlar.

Bir sözlə, ” su nişanları qüsursuz deyil, lakin etiketlər kömək edir ” deyir Siddarth Srinivasan. O, Kembricdəki Harvard Universitetində kompüter alimidir. O, 2024-cü ilin yanvar hesabatında su nişanlarının rolunu nəzərdən keçirib.

Tədqiqatçılar süni intellekt tərəfindən istehsal olunan faylları aşkar etmək üçün alətləri təkmilləşdirməyə davam edəcəklər. Bu arada, bəzi insanlar süni intellektin aşkarlanmasından yayınmağa kömək edəcək yollar üzərində işləməyə davam edəcəklər . Və AI real material istehsalında daha da yaxşılaşacaq. RAND-da Helmus deyir: “Bu, silahlanma yarışıdır”.

Qanunlar AI məzmununun istehsalına bəzi məhdudiyyətlər qoya bilər. Qabaqcıl Tədqiqatlar İnstitutundan Nelson deyir ki, süni intellektə tam nəzarət etmək üçün heç vaxt bir yol olmayacaq, çünki bu sistemlər daim dəyişir. O düşünür ki , süni intellektdən yalnız yaxşı və faydalı işlər görməsini tələb edən siyasətlərə diqqət yetirmək daha yaxşı olar . Deməli, yalan yoxdur.

Keçən ilin oktyabrında prezident Bayden süni intellektə nəzarət etmək üçün fərman verdi. Bildirilib ki, federal hökumət fırıldaqçılıq, qərəzlilik, ayrı-seçkilik, məxfilik pozuntuları və süni intellektdən gələn digər zərərlərlə mübarizə aparmaq üçün mövcud qanunlardan istifadə edəcək. ABŞ-ın Federal Rabitə Komissiyası artıq 1991-ci il qanunundan süni intellekt tərəfindən yaradılan səslərlə robot zəngləri qadağan etmək üçün istifadə edib . Və yeni qanunlar qəbul edən ABŞ Konqresi gələcək tədbirləri nəzərdən keçirir .

Nə edə bilərsən?

Təhsil AI saxtakarlığı tərəfindən qəbul edilməməyin ən yaxşı yollarından biridir. Helmus deyir ki, insanlar bilməlidirlər ki, biz saxtakarların hədəfində ola bilərik və çox vaxt da oluruq.

Yerusəlim İvrit Universitetində Mayo təklif edir ki, xəbərlər, şəkillər və hətta səslər görəndə, onu doğru və ya yalan kimi qəbul etməyə çalışın. Sonra onun etibarlılığını qiymətləndirməyə çalışın. O, bu məsləhəti Psixologiyada Mövcud Rəy jurnalının aprel sayında paylaşıb .

Məlumat axtardığınız yerdə də ehtiyatlı olun, Flinders Universitetində Hopkins əlavə edir. “Həmişə həkiminiz və ya əczaçınız kimi etibarlı sağlamlıq mənbələrindən tibbi məlumat axtarın.” O əlavə edir ki, onlayn mənbələrə, xüsusən də sosial media və süni intellekt chatbotlarına diqqət yetirin. Müəllifləri və onların keçmişini yoxlayın. Veb saytları kimin idarə etdiyinə və maliyyələşdirdiyinə baxın. Həmişə başqa yerdə “faktları” təsdiq edə biləcəyinizi yoxlayın .

Nelson ümid edir ki, indiki uşaqlar və yeniyetmələr süni intellektin saxta iddiaların yayılmasını yavaşlatmağa kömək edəcəklər. “Ümid edirəm ki, bu nəsil mətn və video şəkillərə baxmaq və düzgün suallar vermək üçün daha yaxşı təchiz ediləcəyinə ümid edirəm.”

Əlaqədar Hekayələr

- Süni intellektYeni alət dərin saxta səs fırıldaqlarından qoruya bilərKathryn Hulick tərəfindən15 aprel 2024-cü il

- TechBoru vasitəsilə danışmaq AI-ni bir səsi digəri ilə səhv salmaq üçün aldada bilərKathryn Hulick tərəfindən23 oktyabr 2023-cü il

- Süni intellektGözəl fəaliyyət göstərən süni intellekti necə tərtib etmək olar – və yalnız gözəlKathryn Hulick tərəfindən18 aprel 2024-cü il

Güclü Sözlər

reklam : Reklam üçün qısa. O, hər hansı bir mühitdə (çap, onlayn və ya yayım) görünə bilər və məhsul, ideya və ya nöqteyi-nəzərdən kimisə satmaq üçün hazırlanmışdır.

massiv : Geniş və mütəşəkkil obyektlər qrupu. Bəzən onlar koordinasiyalı şəkildə məlumat toplamaq üçün sistematik şəkildə yerləşdirilən alətlərdir. Digər vaxtlarda massiv bir anda görünən rənglər kimi geniş çeşidli əlaqəli şeyləri edə biləcək şəkildə tərtib edilmiş və ya göstərilən şeylərə istinad edə bilər. Termin hətta bir sıra seçimlərə və ya seçimlərə də aid edilə bilər.

süni intellekt : Maşınlar və ya kompüterlər tərəfindən nümayiş etdirilən biliyə əsaslanan qərar qəbuletmə növü. Termin eyni zamanda elm adamlarının ağıllı davranışa qadir olan maşınlar və ya kompüter proqramları yaratmağa çalışdıqları tədqiqat sahəsinə də aiddir.

audio : Səslə əlaqəlidir.

qərəz : müəyyən bir perspektivə və ya bir şeyə, hansısa qrupa və ya hansısa seçimə üstünlük verən üstünlüklərə sahib olmaq meyli. Alimlər tez-tez subyektləri testin təfərrüatlarına “kor” qoyurlar (onlara bunun nə olduğunu deməyin) ki, onların qərəzləri nəticələrə təsir etməsin.

blog : Veb jurnalı üçün qısaldılmış bu internet yazıları xəbər hesabatları, aktual müzakirələr, fikirli rantlar, gündəliklər və ya foto qalereyalar şəklində ola bilər.

chatbot : İnsan istifadəçiləri ilə zahirən söhbət etmək üçün yaradılmış kompüter proqramı. Müasir olanlar (məsələn, Siri, Alexa, Ocelot və Sprinklr) xəbər hadisələri və ya sinif mövzuları haqqında internet üzərindən məlumat əldə edə bilər. Bir çoxları hətta mağazalar, apteklər və ya banklar adından alışlar, məhsullar və ya planlaşdırma ilə bağlı suallara cavab vermək üçün rəqəmsal köməkçi kimi işləyirlər.

klinik : (tibbdə) İnsanları əhatə edən diaqnoz, müalicə və ya təcrübələrə istinad edən termin.

kod : (hesablamada) Kompüteri bir şey etməyə məcbur edən proqramı yazmaq və ya ona yenidən baxmaq üçün xüsusi dildən istifadə etmək. (n.) Kod həmçinin kompüterin əməliyyatlarını təlimatlandıran proqramlaşdırmanın xüsusi hissələrinin hər birinə aiddir.

həmkar : Başqası ilə işləyən biri; iş yoldaşı və ya komanda üzvü.

informatika : Kompüterlərin prinsipləri və istifadəsinin elmi tədqiqi. Bu sahədə çalışan alimlər kompüter alimləri kimi tanınırlar.

Konqres : ABŞ federal hökumətinin qanunlar yazmaq, ABŞ büdcəsini təyin etmək və bir çox prezidentin məhkəmələrə təyinatlarını təsdiqləmək, ABŞ hökumətinin maraqlarını xaricdə təmsil etmək və inzibati agentlikləri idarə etmək vəzifəsi daşıyan hissəsi. ABŞ Konqresi iki hissədən ibarətdir: hər bir ştatdan iki üzvdən ibarət Senat və hər bir ştatdan ən azı bir nəfərin (və digər ştatlar üçün onlarla daha çox) cəmi 435 üzvdən ibarət olan Nümayəndələr Palatası. ən böyük əhali).

demokratiya : insanların xalq tərəfindən idarə edildiyi (məsələn, kraldan fərqli olaraq) və qərarların idarə olunanların əksəriyyəti tərəfindən seçilən seçilmiş məmurlar tərəfindən qəbul edildiyi bir idarəetmə forması.

diffuziya modelləri : (süni intellektdə) AI tərəfindən yaradılan real görüntülərin istehsalına yanaşma. Təlim zamanı model şəkil çəkir və çoxlu səs-küy və ya müdaxilə əlavə edir. Sonra səs-küydən xilas olmaq üçün təsviri təmizləyir. Model daha sonra öyrəndiklərini istifadəçilər üçün yeni şəkillər yaratmaq üçün istifadə edə bilər. Yaranan şəkillər çox real görünə bilər.

rəqəmsal : (informatika və mühəndislikdə) Bir şeyin kompüterdə və ya başqa bir elektron cihazda ikili sistemə əsaslanaraq rəqəmsal şəkildə işlənib hazırlandığını göstərən sifət (burada bütün nömrələr yalnız sıfırlar və birlər seriyasından istifadə edilməklə göstərilir).

ayrı-seçkilik : (sosial elmdə) bir və ya bir neçə atributuna (məsələn, irq, cins, din və ya yaş) dair qərəzliliyə əsaslanan insanlara və ya əşyalara yenidən qərəzli münasibət. Bu, fərdin hərəkətlərinə deyil, əksinə, bütün qrupa geniş şəkildə tətbiq olunan hələ əsassız gözləntilərə əsaslanır.

Epidemioloq : Sağlamlıq detektivləri kimi, bu tədqiqatçılar da müəyyən bir xəstəliyi ona səbəb ola biləcək və/və ya yayılmasına imkan verən şeylə əlaqələndirməyə çalışırlar.

amil : Müəyyən şəraitdə və ya hadisədə rol oynayan bir şey; töhfə verən.

Federal Rabitə Komissiyası : ABŞ Konqresi tərəfindən idarə olunan ABŞ hökumətinin müstəqil agentliyidir. O, rabitəni tənzimləyir və ABŞ ştatları arasında və Birləşmiş Ştatlar ilə digər dövlətlər arasında əlaqəni əhatə edən ABŞ qanunlarını tətbiq edir. Bu rabitə radio, televiziya, naqil, peyk və kabel vasitəsilə ola bilər.

fırıldaqçılıq : aldatmaq; ya da aldatma yolu ilə edilən bir şeyin nəticəsi. Yaxud səhv etmək və qəsdən səhvi ört-basdır etmək.

nəsil : Təxminən eyni zamanda doğulmuş və ya tək bir qrup kimi qəbul edilən fərdlər qrupu (hər hansı növdə). Valideynləriniz, məsələn, ailənizin bir nəslinə, babalarınız isə digərinə aiddir. Eynilə, siz və sizin yaşınızdan bir neçə il ərzində planetdəki hər kəs müəyyən bir insan nəslinə aid edilir. Termin bəzən digər heyvanların illik siniflərinə və ya cansız obyektlərin növlərinə (məsələn, elektronika və ya avtomobillər) aid edilir.

generativ rəqib şəbəkə (və ya GAN ): AI tərəfindən yaradılan real görüntülərin istehsalına yanaşma. Şəbəkədəki sistemlərdən biri generatordur. Onun işi detektiv kimi işləyən başqa bir hissədən gələn rəyə cavab olaraq daha yaxşı və daha real görüntülər yaratmaqdır. Detektiv generatorun saxta görüntülərində nəyinsə səhv olduğunu göstərən əlamətlər axtarır. Bir nöqtədə generatordan bir görüntü detektivi aldatmayacaq. Bu, modelin çıxışına çevrilir.

generativ AI : İstifadəçinin sorğusuna cavab olaraq mətnlər, şəkillər, audio və ya video yaratmaq — yaratmaq üçün dərin öyrənmə və neyron şəbəkələrdən istifadə edən süni intellekt modelləri sinfi.

magistr tələbəsi : Dərslər alaraq və tədqiqat apararaq qabaqcıl dərəcəyə doğru çalışan kimsə. Bu iş tələbə artıq kolleci bitirdikdən sonra həyata keçirilir (adətən dörd illik dərəcə ilə).

orta məktəb : ABŞ-ın icbari dövlət təhsili sistemində doqquzuncudan 12-yə qədər olan siniflər üçün təyinat. Orta məktəbi bitirənlər əlavə, təkmil təhsil almaq üçün kolleclərə müraciət edə bilərlər.

daxili xəstəliklər : Həkimlərin böyüklərə cərrahi müdaxiləyə ehtiyacı olmayan şərtləri diaqnoz və müalicə etdikləri tibb sahəsi. Bu sahədə çalışan həkimlər internist kimi tanınır.

dəniz : Okean dünyası və ya ətraf mühitlə əlaqəsi olan.

media : İnformasiyanın cəmiyyət daxilində çatdırılması və paylaşılması üsulları üçün termin. Bu, təkcə ənənəvi medianı – qəzetlər, jurnallar, radio və televiziyaları deyil, həm də Twitter, Facebook, Instagram, TikTok və WhatsApp kimi rəqəmsal şəbəkələri əhatə edir. Daha yeni, rəqəmsal media bəzən sosial media olaraq adlandırılır. Bu terminin tək forması ortadır.

şəbəkə : Bir-biri ilə əlaqəli insanlar və ya əşyalar qrupu. (v.) Müəyyən bir ərazidə işləyən və ya oxşar işlərlə məşğul olan digər insanlarla (məsələn, sənətçilər, biznes liderləri və ya tibbi dəstək qrupları) tez-tez belə insanların gözlənildiyi yığıncaqlara getmək və sonra söhbət etməklə əlaqə yaratmaq aktı onları yuxarı. (n. şəbəkə)

piksel : Şəkil elementi üçün qısadır. Kompüter ekranındakı kiçik işıqlandırma sahəsi və ya çap edilmiş səhifədəki nöqtə, adətən rəqəmsal görüntü yaratmaq üçün massivdə yerləşdirilir. Fotoşəkillər minlərlə pikseldən ibarətdir, hər biri fərqli parlaqlıq və rəngdədir və hər biri şəkil böyüdülməsə görünməyəcək qədər kiçikdir.

siyasət : Müəyyən xüsusi şəraitdə tətbiq ediləcək plan, bəyan edilmiş təlimatlar və ya razılaşdırılmış fəaliyyət qaydaları. Məsələn, bir məktəbdə qarlı günlərə nə vaxt icazə veriləcəyi və ya bir il ərzində bir şagirdə nə qədər üzrlü dərsə icazə veriləcəyi ilə bağlı siyasət ola bilər.

siyasi : (n. siyasət ) Şəhərləri, ştatları, millətləri və ya digər insan qruplarını idarə etmək vəzifəsi daşıyan insanların fəaliyyətinə aid olan sifət. Bu, qanunların yaradılması və ya dəyişdirilməsi, idarə olunan icmalar üçün siyasətlərin müəyyən edilməsi, qaydaları və ya vergiləri və ya qanunların şərhini dəyişdirmək istəyən insanlar və ya qruplar arasında münaqişələri həll etmək cəhdlərini əhatə edə bilər. Bu vəzifələri bir iş (peşə) kimi üzərinə götürən insanlar siyasətçi kimi tanınır .

psixoloq : Xüsusilə hərəkətlər və davranışlarla bağlı zehni öyrənən alim və ya psixi sağlamlıq mütəxəssisi. Bəziləri insanlarla işləyir. Digərləri, beyinlərinin müxtəlif stimullara və şərtlərə necə reaksiya verdiyini yoxlamaq üçün heyvanlarla (adətən gəmiricilər) təcrübələr keçirə bilər.

təsadüfi : Təsadüfi və ya səbəbsiz baş verən, heç bir niyyət və məqsədə əsaslanmayan bir şey. Və ya heç bir səbəb olmadan, hətta xaotik olaraq seçilən bir şeyi təsvir edən bir sifət.

sosial media : İnsanların bir-biri ilə əlaqə saxlamasına (çox vaxt anonim) və məlumat paylaşmasına imkan verən rəqəmsal media. Məsələn, Twitter, Facebook, Instagram, TikTok və WhatsApp.

sosioloq : İnsan qruplarının davranışlarını, bu davranışların necə inkişaf etdiyini və insanların cəmiyyətləri (cəmiyyətlərini) dəstəkləmək üçün yaratdıqları təşkilatları öyrənən alim.

incə : Vacib ola biləcək, lakin görmək və ya təsvir etmək çətin ola biləcək bir şey üçün sifət. Məsələn, xərçəngin başlanğıcını siqnal edən ilk hüceyrə dəyişiklikləri kiçik və yaxınlıqdakı sağlam toxumalardan ayırd etmək çətin olduğu kimi, yalnız bir qədər fərqli ola bilər.

sistem : Bəzi funksiyaları yerinə yetirmək üçün birlikdə işləyən hissələr şəbəkəsi. Məsələn, qan, damarlar və ürək insan bədəninin qan dövranı sisteminin əsas komponentləridir. Eynilə, qatarlar, platformalar, yollar, yol siqnalları və yerüstü keçidlər bir ölkənin dəmir yolu sisteminin potensial komponentləri arasındadır. Sistem hətta hansısa metodun bir hissəsi olan proseslərə və ya ideyalara və ya tapşırığı yerinə yetirmək üçün sifarişli prosedurlar toplusuna tətbiq oluna bilər.

tweet : X (əvvəllər Twitter) ilə onlayn hesabı olan insanlar üçün əlçatan olan 280 və ya daha az simvoldan ibarət mesaj. 2017-ci ilin noyabrından əvvəl limit 140 simvol idi.

peyvənd : (v. vaccinate) Xəstəlik törədən agentə bənzəyən bioloji qarışıq. Bədənin müəyyən bir xəstəliyə qarşı immunitet yaratmasına kömək etmək üçün verilir. Peyvəndlərin əksəriyyətini tətbiq etmək üçün istifadə edilən iynələr peyvəndlər kimi tanınır.

vaping : (v. to vape) Elektron siqaretlərin istifadəsi üçün jarqon termindir, çünki bu cihazlar tüstü deyil, buxar yayır. Bunu edən insanlara vaper deyilir.

su nişanı : Kağız üzərində çap edilmiş, adətən yalnız müəyyən istiqamətdə və ya işığa qarşı tutulduqda görünən incə təsvir. Bu çoxəsrlik texnologiya saxtakarlığın qarşısını almaq üçün orijinal sənəd yaratmağa kömək edir. 1990-cı illərdə yaradıcını müəyyən etmək üçün sənədin və ya fotoşəkilin (və ya audio faylın üstünə səsin) üzərinə yüngül təsviri qoyan yeni “rəqəmsal su nişanları” ortaya çıxdı.

külək turbini : Küləklə işləyən cihaz – çoxdan taxıl dəyirmanı (külək dəyirmanları) üçün istifadə olunan tipə bənzər – elektrik enerjisi istehsal etmək üçün istifadə olunur.

Sitatlar

Jurnal: R. Mayo. Güvən yoxsa inamsızlıq? Heç də! Dezinformasiya ilə mübarizə üçün düzgün düşüncə tərzi . Psixologiyada Mövcud Rəy . Cild. 56, aprel 2024. doi: 10.1016/j.copsyc.2023.101779.

Hesabat: A. Swenson və K. Chan. Seçki dezinformasiyası dünya miqyasında aldatmaq üçün istifadə edilən süni intellektlə böyük sıçrayış edir . Associated Press . 14 mart 2024-cü il.

Sənəd: R. Vinay et al. Sürətli mühəndislik vasitəsilə emosional manipulyasiya süni intellekt böyük dil modellərində dezinformasiya nəslini gücləndirir . 6 mart 2024-cü il arXiv-ə təqdim edilmişdir. doi: 10.48550/arXiv.2403.03550.

Hesabat: J. Angwin, A. Nelson və R. Palta. Etibarlı seçki məlumatı axtarırsınız? AI-yə etibar etməyin . AI Demokratiya Layihələri. 27 fevral 2024-cü il.

Görüş: S. Chang et al. Panel: Empirik və Texnoloji Suallar: Mövcud mənzərə, çağırışlar və imkanlar . Simpozium: Generativ süni intellekt, Azad Söz və İctimai Söhbət. Nyu York, NY 20 fevral 2024-cü il.

Hesabat: J. Shapero. FCC, Bayden əsas dərin saxtakarlığından sonra süni intellekt tərəfindən yaradılan robot zəngləri hədəfləyir . Təpə . 1 fevral 2024-cü il.

Jurnal: B. Menz et al. Sağlamlıq dezinformasiyasından istifadə halı süni intellektin sayıqlığına təcili ehtiyac olduğunu vurğulayır . JAMA Daxili Xəstəliklər . Cild. 184, yanvar 2024, səh. 92. doi: 10.1001/jamainternmed.2023.5947.

Jurnal : A. Nelson . Süni intellektə nəzarət etməyin düzgün yolu: onun təhlükələrinə deyil, imkanlarına diqqət yetirin . Xarici İşlər . 12 yanvar 2024-cü il.

Hesabat: S. Srinivasan. Süni intellekt barmaq izlərinin aşkarlanması: su nişanı və ondan kənara dair bələdçi . Brookings İnstitutu. Vaşinqton, DC 4 yanvar 2024-cü il.

Jurnal : M. Novak. Donald Tramp yalandan iddia edir ki, hücum reklamında onu pis göstərmək üçün süni intellektdən istifadə olunub . Forbes . 4 dekabr 2023-cü il (5 dekabr yeniləndi).

Jurnal: BD Menz et al. Süni intellektin sayıqlığına təcili ehtiyacı vurğulayan sağlamlıq dezinformasiyasından istifadə halı: Kütləvi dezinformasiya silahları . JAMA Daxili Xəstəliklər . Cild. 184, 12 noyabr 2023-cü il, səh. 92. doi: 10.1001/jamainternmed.2023.5947.

Jurnal: G. Spitale, N. Biller-Andorino və F. Germani. AI modeli GPT-3 (dis) bizi insanlardan daha yaxşı məlumatlandırır . Elmdə irəliləyişlər . Cild. 9, 28 iyun 2023. doi: 10.1126/sciadv.adh1850.

Görüş: J. Pu et al. Deepfake mətn aşkarlanması: Məhdudiyyətlər və imkanlar . 2023 IEEE Təhlükəsizlik və Məxfilik Simpoziumu . Cild. 2023, 23 may 2023, səh. 1613. San Fransisko, Kaliforniya doi: 10.1109/SP46215.2023.10179387.

Jurnal: T. Helmus. Süni intellekt, dərin saxtakarlıqlar və dezinformasiya: primer . RAND. 2022. doi: https://doi.org/10.7249/PEA1043-1.

Jurnal: M. Moshel et al. Həqiqətən sənsən ? Sinir fəaliyyətindən AI tərəfindən yaradılan real üzlərin deşifrə edilməsi . Vizyon Araşdırması . Cild. 199, oktyabr 2022. doi: 10.1016/j.visres.2022.108079.

Kathiann Kowalski haqqında

Kathiann Kowalski bütün qabaqcıl elmlər haqqında məlumat verir. Əvvəllər o, böyük bir firmada vəkillik edib. Kathi gəzinti, tikiş və kitab oxumağı sevir. O, həmçinin səyahətləri, xüsusən də ailə macəralarını və çimərlik səyahətlərini sevir.