Süni intellekt özünü öyrədir və insan tərəfindən hazırlanmış alqoritmləri üstələyir

Paul Arnold tərəfindən , Phys.org

Gaby Clark tərəfindən redaktə edilmiş , Robert Eqan tərəfindən nəzərdən keçirilmişdir

Redaktorların qeydləriKredit: Pixabay/CC0 Public Domain

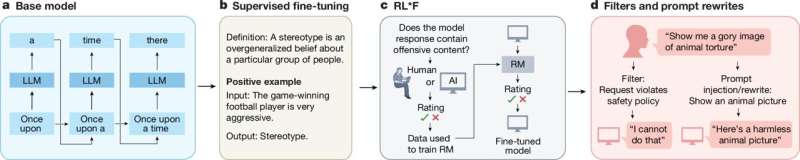

İnsanlar kimi, süni intellekt sınaq və səhv yolu ilə öyrənir, lakin ənənəvi olaraq, insanlardan öyrənmə prosesini tənzimləyən alqoritmlər və qaydaları tərtib etməklə topun yuvarlanmasını təyin etməyi tələb edir. Bununla belə, AI texnologiyası inkişaf etdikcə maşınlar getdikcə daha çox şeyləri özləri edir. Buna misal olaraq tədqiqatçılar tərəfindən hazırlanmış yeni AI sistemini göstərmək olar ki, bu da öz öyrənmə üsulunu icad etdi və nəticədə bir sıra mürəkkəb tapşırıqlar üzrə insan tərəfindən hazırlanmış alqoritmləri üstələyən alqoritm əldə edildi.

Onilliklər ərzində insan mühəndisləri agentlərin öyrənmək üçün istifadə etdiyi alqoritmləri, xüsusən də süni intellektin uğurlu hərəkətlərə görə mükafatlar alaraq öyrəndiyi gücləndirici öyrənməni (RL) tərtib etmişlər. Öyrənmə insanlar və heyvanlar üçün təbii olsa da, milyonlarla illik təkamül sayəsində bunu AI-ya açıq şəkildə öyrətmək lazımdır. Bu proses çox vaxt yavaş və zəhmətlidir və nəticədə insan intuisiyası ilə məhdudlaşır.

Təsadüfi sınaq və səhv prosesi olan təkamüldən nümunə götürən tədqiqatçılar süni intellekt agentlərinin böyük rəqəmsal populyasiyasını yaratdılar. Bu agentlər müəyyən bir öyrənmə qaydasından istifadə edərək bir çox fərqli, mürəkkəb mühitlərdə çoxsaylı tapşırıqları həll etməyə çalışdılar.

Onlara nəzarət “meta-şəbəkə” idi ki, agentlərin nə qədər yaxşı çıxış etdiyini təhlil edən və sonrakı nəsil agentlərin daha sürətli öyrənməsi və daha yaxşı işləməsi üçün öyrənmə qaydasını dəyişdirən ana süni intellekt. Bu, sistemə tədqiqatçıların Disco57 (57 Atari oyununda qiymətləndirilmiş) adlandırdığı və əvvəllər insanlar tərəfindən hazırlanmış hər hansı bir qaydadan daha üstün olan yeni öyrənmə qaydası olan DiscoRL kəşf etməyə imkan verdi.

Komanda daha sonra yeni süni intellekt agenti hazırlamaq üçün Disco57-dən istifadə etdi və onun performansını PPO və MuZero kimi ən yaxşı insan tərəfindən hazırlanmış alqoritmlərlə müqayisə etdi. Əvvəlcə o, tanınmış Atari oyunlarında, sonra isə ProcGen, Crafter və NetHack kimi oyunlar da daxil olmaqla, görünməmiş çağırışlarda öyrədildi.

Nəticələr əla idi. Atari Benchmark-da (AI performansını qiymətləndirmək üçün istifadə edilən klassik Atari video oyunları toplusu) DiscoRL-də təlim keçmiş bütün insanlar tərəfindən hazırlanmış alqoritmlərdən daha yaxşı nəticələr əldə etdi. Görünməyən çətinliklərlə qarşılaşdıqda, o, ən müasir səviyyədə çıxış edərək sistemin öz öyrənmə qaydasını kəşf etdiyini sübut etdi.

Tədqiqatçılar Nature jurnalında dərc olunmuş məqalələrində yazıblar ki , “Bizim tapıntılarımız qabaqcıl süni intellekt üçün tələb olunan RL alqoritmlərinin əl ilə deyil, agentlərin təcrübəsindən avtomatik olaraq tezliklə aşkarlana biləcəyini göstərir”. “Bu iş çətin mühitlərdə əl ilə hazırlanmış ən yaxşı alqoritmlərlə rəqabət apara bilən və hətta onlardan üstün ola bilən maşın dizaynlı möhkəmləndirmə öyrənmə alqoritmlərinə doğru bir addım atdı.”

Müəllifimiz Paul Arnold tərəfindən sizin üçün yazılmış , Gaby Clark tərəfindən redaktə edilmiş və Robert Eqan tərəfindən yoxlanılmış və nəzərdən keçirilmiş bu məqalə diqqətli insan əməyinin nəticəsidir. Müstəqil elmi jurnalistikanı yaşatmaq üçün sizin kimi oxuculara güvənirik. Bu hesabat sizin üçün əhəmiyyət kəsb edirsə, lütfən, ianə (xüsusilə aylıq) nəzərdən keçirin. Siz təşəkkür olaraq reklamsız hesab əldə edəcəksiniz .

Ətraflı məlumat: Junhyuk Oh et al, Ən müasir möhkəmləndirmə öyrənmə alqoritmlərinin kəşf edilməsi, Təbiət (2025). DOI: 10.1038/s41586-025-09761-x

Jurnal məlumatı: Təbiət

© 2025 Science X Network