Süni intellekt silahları müharibədə təhlükəlidir. Lakin onların məsuliyyətə cəlb edilə bilməyəcəyini söyləmək mətləbi qaçırır

Zena Əsəd, Söhbət

Gaby Clark tərəfindən redaktə edilmişdir , Andrew Zinin tərəfindən nəzərdən keçirilmişdir

Redaktorların qeydləriKredit: Pexels-dən Sami TÜRK

Avstraliyanın Xarici İşlər Naziri Penni Vonq keçən ay Birləşmiş Millətlər Təşkilatının Təhlükəsizlik Şurasında etdiyi çıxışda süni intellektə (AI) diqqət çəkib.

O, texnologiyanın səhiyyə və təhsil kimi sahələrdə “fövqəladə vədlər verdiyini” desə də, onun nüvə silahları və pilotsuz sistemlərdə potensial istifadəsinin bəşəriyyətin gələcəyinə meydan oxuduğunu da söylədi: “Nüvə müharibəsi indiyə qədər insan mühakiməsi ilə məhdudlaşdırılıb. Məsuliyyəti daşıyan liderlər və insan vicdanı. Süni intellekt belə bir təhlükəyə malik deyil və bu silahların özləri də bu təhlükəyə cavabdeh ola bilməzlər. xəbərdarlıq etmədən eskalasiya”.

Bu fikir – AI müharibəsi unikal təhlükə yaradır – tez-tez bu texnologiyanı qorumaq üçün ictimai zənglərdə təqdim olunur . Ancaq həm texnologiya, həm də müharibə haqqında müxtəlif təhriflər bulanıqdır.

Bu, suallar doğurur: süni intellekt həqiqətən müharibənin təbiətini dəyişəcəkmi? Və həqiqətən məsuliyyətsizdirmi?

Süni intellekt müharibədə necə istifadə olunur?

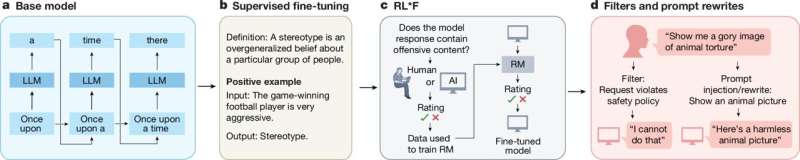

Süni intellekt heç də yeni texnologiya deyil, termin ilk olaraq 1950-ci illərdə icad edilmişdir . Bu, indi böyük dil modellərindən tutmuş kompüter görmə qabiliyyətinə və neyron şəbəkələrinə qədər hər şeyi əhatə edən çətir terminə çevrilmişdir – bunların hamısı çox fərqlidir.

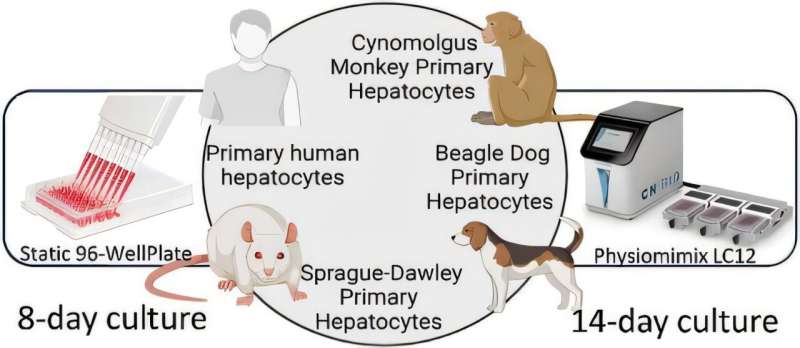

Ümumiyyətlə, süni intellekt tətbiqləri mətn göstərişləri kimi daxilolmalardan, proqnozlar, məzmun, tövsiyələr və ya qərarlar kimi çıxışların necə yaradılacağını nəticə çıxarmaq üçün verilənlərdəki nümunələri təhlil edir. Lakin bu sistemlərin öyrədilməsinin əsas yolları, hamısının “AI” kimi etiketlənməsinə baxmayaraq, həmişə müqayisə edilə bilməz .

Müharibədə süni intellektdən istifadə əsgərlərin təlimi üçün istifadə edilən döyüş oyunu simulyasiyalarından tutmuş hədəf təyin etmək üçün istifadə edilən daha problemli süni intellektlə qərar qəbul etmə sistemlərinə qədər, məsələn, İsrail Müdafiə Qüvvələrinin HƏMAS və ya digər silahlı qrupların şübhəli üzvlərini müəyyən edən “Lavanda” sistemindən istifadə etməsi kimi.

Hərbi sahədə süni intellektlə bağlı geniş müzakirələr bu nümunələrin hər ikisini əhatə edir, o zaman ki, ölüm-dirim qərarının qəbulu nöqtəsində yalnız sonuncusu oturur. Müharibə kontekstində süni intellektlə bağlı əxlaqi müzakirələrin əksəriyyətində məhz bu məqam üstünlük təşkil edir.

https://googleads.g.doubleclick.net/pagead/ads?gdpr=0&us_privacy=1—&gpp_sid=-1&client=ca-pub-0536483524803400&output=html&h=280&slotname=8188791252&adk=1751428779&adf=308666314&pi=t.ma~as.8188791252&w=540&fwrn=4&fwrnh=0&lmt=1760357365&rafmt=1&armr=3&format=540×280&url=https%3A%2F%2Fphys.org%2Fnews%2F2025-10-ai-weapons-dangerous-war-held.html&fwr=0&rpe=1&resp_fmts=3&wgl=1&aieuf=1&uach=WyJXaW5kb3dzIiwiMTAuMC4wIiwieDg2IiwiIiwiMTQwLjAuNzMzOS4yMDgiLG51bGwsMCxudWxsLCI2NCIsW1siQ2hyb21pdW0iLCIxNDAuMC43MzM5LjIwOCJdLFsiTm90PUE_QnJhbmQiLCIyNC4wLjAuMCJdLFsiR29vZ2xlIENocm9tZSIsIjE0MC4wLjczMzkuMjA4Il1dLDBd&abgtt=6&dt=1760357365464&bpp=1&bdt=155&idt=52&shv=r20251009&mjsv=m202510070101&ptt=9&saldr=aa&abxe=1&cookie=ID%3Df6049ed7e99f41d6%3AT%3D1758189974%3ART%3D1760357061%3AS%3DALNI_MaaPMCT0xh3cG3vjPdhDrCm-4bmsQ&gpic=UID%3D000011649d2287ad%3AT%3D1758189974%3ART%3D1760357061%3AS%3DALNI_MYn_5IniDsN9mR9RitcGLlhmM6RdA&eo_id_str=ID%3D7ecb922b825847ec%3AT%3D1758189974%3ART%3D1760357061%3AS%3DAA-Afjb6HIEPaknKAwak0Eq3BEfy&prev_fmts=0x0&nras=1&correlator=2068185404100&frm=20&pv=1&rplot=4&u_tz=240&u_his=5&u_h=864&u_w=1536&u_ah=824&u_aw=1536&u_cd=24&u_sd=1.25&dmc=8&adx=395&ady=2338&biw=1521&bih=738&scr_x=0&scr_y=0&eid=31095145%2C31095147%2C31095150%2C31095154%2C95371226%2C42533293%2C95344791&oid=2&pvsid=6697900365462292&tmod=1878193225&uas=0&nvt=1&ref=https%3A%2F%2Fphys.org%2F&fc=1920&brdim=0%2C0%2C0%2C0%2C1536%2C0%2C1536%2C824%2C1536%2C738&vis=1&rsz=%7C%7CpeEbr%7C&abl=CS&pfx=0&fu=128&bc=31&bz=1&td=1&tdf=2&psd=W251bGwsbnVsbCxudWxsLDFd&nt=1&ifi=2&uci=a!2&btvi=1&fsb=1&dtd=226

Həqiqətən məsuliyyət boşluğu varmı?

Bir şey səhv getdikdə kimin və ya nəyin məsuliyyət daşıdığına dair arqumentlər AI-nin həm mülki, həm də hərbi tətbiqlərini əhatə edir. Bu çətin vəziyyətə “məsuliyyət boşluğu” damğası vurulmuşdur .

Maraqlıdır ki, mediada müharibədə ölüm-dirim qərarları verən “qatil robotlar” haqqındakı xəbərlərdən qaynaqlanan bu hesabatlılıq boşluğu digər texnologiyalara gəldikdə nadir hallarda müzakirə olunur.

Məsələn, idarə olunmayan raketlər və ya minalar kimi köhnə silahlar var ki, onların əməliyyatlarının ən ölümcül hissəsində heç bir insan nəzarəti və ya nəzarəti yoxdur. Ancaq heç kim idarə olunmayan raketin və ya minanın günahkar olub olmadığını soruşmur.

Eynilə, Avstraliyadakı Robodebt qalmaqalı, borcları hesablamaq üçün güvəndiyi avtomatlaşdırılmış sistem deyil, federal hökumətin adından sui-istifadə gördü .

Bəs niyə AI-nin günahkar olub olmadığını soruşuruq?

Hər hansı digər mürəkkəb sistem kimi, AI sistemləri də insanlar tərəfindən dizayn edilir, inkişaf etdirilir, əldə edilir və yerləşdirilir. Hərbi kontekstlər üçün əlavə komanda və nəzarət təbəqəsi , hərbi məqsədlərə nail olmaq üçün qərar qəbuletmə iyerarxiyası mövcuddur .

AI bu iyerarxiyadan kənarda mövcud deyil. Süni intellekt sistemləri tərəfindən müstəqil qərar qəbul etmə ideyası, bu sistemlərin əslində necə işlədiyini və sistemin müxtəlif tətbiqlərdə istifadə edilməsinə hansı proseslər və təcrübələrin səbəb olduğunu başa düşməkdən qaynaqlanır.

Süni intellekt sistemlərinin cavabdeh ola bilməyəcəyini söyləmək düzgün olsa da, bu da artıqdır. Heç bir cansız obyekt heç bir halda heç bir halda məsuliyyətə cəlb edilə bilməz və ya heç vaxt məsuliyyətə cəlb edilə bilməz – istər avtomatlaşdırılmış borc qaytarma sistemi, istərsə də hərbi silah sistemi.

Sistem adından hesabatlılıq arqumenti nə burada, nə də oradadır, çünki nəticədə qərarlar və bu qərarların məsuliyyətləri həmişə insan səviyyəsindədir.

Gündəlik anlayışlar üçün Phys.org-a etibar edən 100.000-dən çox abunəçi ilə elm, texnologiya və kosmosda ən son yenilikləri kəşf edin . Pulsuz xəbər bülleteni üçün qeydiyyatdan keçin və mühüm nailiyyətlər, yeniliklər və tədqiqatlar haqqında gündəlik və ya həftəlik yeniləmələr əldə edin .

Həmişə insanlara qayıdır

Süni intellekt sistemləri də daxil olmaqla bütün mürəkkəb sistemlər bir sistemin həyat dövrü boyunca mövcuddur : sistemin ilkin konsepsiyadan son təqaüdə çıxmasına qədər strukturlaşdırılmış və sistematik bir prosesdir.

İnsanlar həyat dövrünün hər mərhələsində şüurlu qərarlar qəbul edirlər: planlaşdırma, dizayn, inkişaf, həyata keçirmə, istismar, texniki xidmət. Bu qərarlar texniki mühəndislik tələblərindən tutmuş normativlərə uyğunluq və əməliyyat təminatlarına qədər dəyişir.

Bu həyat dövrü strukturunun yaratdığı şey aydın müdaxilə nöqtələri olan bir məsuliyyət zənciridir .

Bu o deməkdir ki, süni intellekt sistemi tətbiq olunduqda onun xüsusiyyətləri, o cümlədən onun nasazlıqları və məhdudiyyətləri məcmu insan qərarlarının məhsuludur.

Hədəf üçün istifadə edilən AI silah sistemləri həyat və ölümlə bağlı qərarlar qəbul etmir. Bu kontekstdə o sistemi istifadə etməyi şüurlu şəkildə seçən insanlardır.

Beləliklə, biz süni intellekt silah sistemlərini tənzimləmək haqqında danışarkən, həqiqətən, tənzimlədiyimiz şey, bu sistemlərin həyat dövründə iştirak edən insanlardır.

Müharibənin təbiətini dəyişdirən süni intellekt ideyası insanların hərbi qərarların qəbulunda oynadığı rolların reallığını kölgədə qoyur. Baxmayaraq ki, bu texnologiya çətinliklər yaradır və təqdim etməkdə davam edəcək, bu çətinliklər həmişə insanlara qayıdır.

The Conversation tərəfindən təmin edilmişdir

Bu məqalə Creative Commons lisenziyası ilə The Conversation -dan yenidən nəşr edilmişdir. Orijinal məqaləni oxuyun .