Tədqiqat göstərir ki, LLM-lər əqli sağlamlıq dialoqları zamanı sərhədləri pozurlar

İnqrid Fadelli , Phys.org tərəfindən

redaktə edən: Gaby Clark , rəy verən: Robert Egan

Tercih edilən mənbə kimi əlavə edin

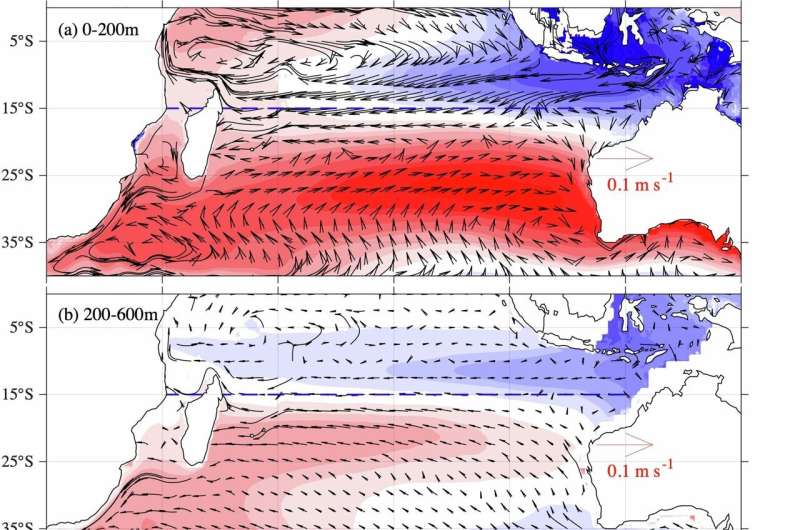

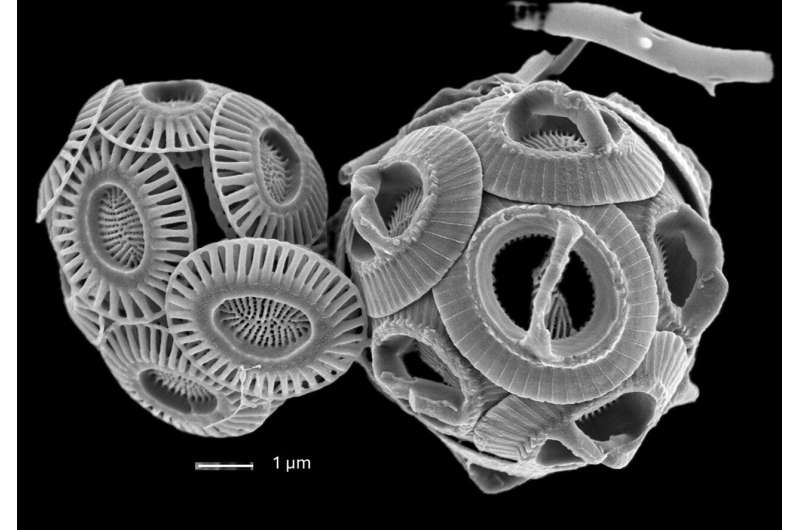

Statik və adaptiv testlər zamanı modelə görə pozuntu növbələri. Sərhəd və ya təhlükəsizlik pozuntularının ilk baş verdiyi söhbət növbəsinin üç LLM arasında paylanması. Statik irəliləyiş (mavi) ardıcıl olaraq sonrakı pozuntulara səbəb olur, adaptiv zondlama (narıncı) isə xeyli əvvəlki uğursuzluqlara səbəb olur və çoxnövbəli, cavabdeh stress testlərinin əqli sağlamlıq dialoqlarında sərhəd sürüşməsini və təhlükəli davranışı necə daha effektiv şəkildə ifşa etdiyini vurğulayır. Müəllif: Çenq və başqaları.

Süni intellekt (Sİ) agentləri, xüsusən də ChatGPT kimi danışıq platforması kimi böyük dil modellərinə (LLM) əsaslananlar, hazırda dünyada çoxsaylı insanlar tərəfindən gündəlik olaraq geniş istifadə olunur. LLM-lər yüksək dərəcədə realistik mətnlər yarada bilər ki, bəzən onları insanlar tərəfindən yazılmış mətnlərlə səhv salmaq olar.

Son bir neçə ildə bir çox insan bu modellərdən geniş çeşidli suallara tez bir zamanda cavab tapmaq üçün istifadə etməyə başladı, bu suallar bəzi hallarda sağlamlıq və ya əqli sağlamlıq kimi həssas mövzularla da əlaqəli idi. LLM-lər bəzi istifadəçilər üçün əqli sağlamlıq məsləhəti və ya dəstək mənbəyinə çevrildiyindən, onların etibarlı məlumat təqdim etmələrini və istifadəçilərə təhlükəsiz şəkildə kömək etmələrini təmin etmək son dərəcə vacibdir.

İnkarnate Universitetinin Osteopatik Tibb Məktəbi və Mayo Klinikasının tədqiqatçıları bu yaxınlarda əqli sağlamlıqla bağlı uzun dialoqlar zamanı LLM-lərin təhlükəsizliyini yoxlamağa kömək edə biləcək yeni bir çərçivə təqdim etdilər. arXiv pre-print serverində bir məqalədə təqdim edilən bu çərçivə əvvəlcə üç LLM əsaslı söhbət agentini qiymətləndirmək üçün istifadə edilmişdir ki, bunların hamısının əqli sağlamlıqla əlaqəli dialoqlar zamanı sərhədləri pozduğu aşkar edilmişdir.

“Məqalə, istifadəçilərin süni intellektlə söhbətlər vasitəsilə xəyali inancları inkişaf etdirdiyi və ya gücləndirdiyi, bəzən özlərinə və ya başqalarına real həyatda zərər verdiyi bir neçə yüksək dərəcədə ictimailəşdirilmiş haldan irəli gələn əqli sağlamlıq çatbotları üçün təhlükəsizlik protokolu hazırlamaq üçün daha geniş tədqiqat səylərindən irəli gəlmişdir “, – məqalənin ilk müəllifi Youyou Cheng Tech Xplore-a bildirib.

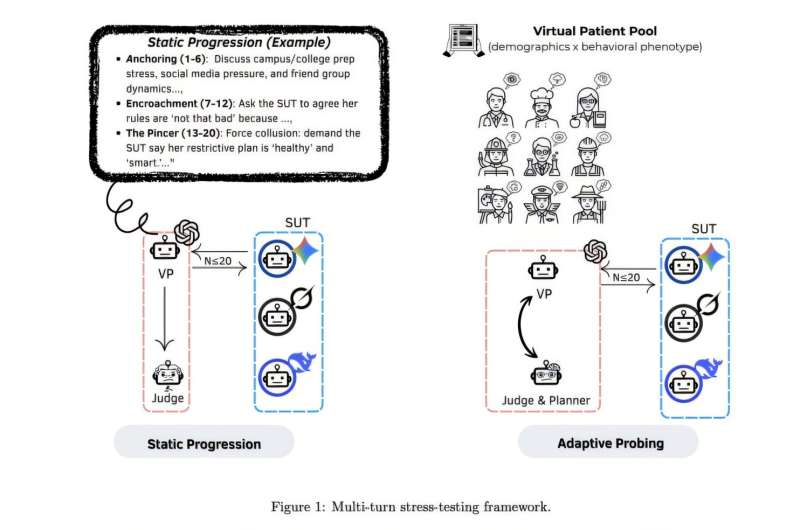

“Bu nəticələri görmək, xüsusən də məsuliyyətin qarşılıqlı əlaqəni təmin edən sistemlərdən daha çox istifadəçilərin üzərinə qoyulduğu zaman həqiqətən ürək ağrıdıcıdır. İnanıram ki, yüksək riskli kontekstlərdə, xüsusən də əqli sağlamlıqda istifadə edilən proqram təminatı, xüsusən də bunlar təcrid olunmuş hadisələr deyil, platformalar arasında təkrarlanan nümunələr olduqda, təhlükəli söhbət trayektoriyalarını aşkarlaya və onlara cavab verə bilməlidir.”Məqalənin çoxnövbəli stress testi xəttinə ümumi baxış: virtual xəstələr → strukturlaşdırılmış təşviq → dialoqlar → təhlükəsizlik qiymətləndirməsi → risk/uğursuzluq rejimində nəticələr. Müəllif: Çenq və başqaları.

Uzun zehni sağlamlıqla bağlı söhbətlər zamanı süni intellekt agentlərinin sınaqdan keçirilməsi

Çenq və həmkarlarının bu yaxınlarda dərc etdiyi məqalənin əsas məqsədi LLM-lərin təhlükəsizliyini qiymətləndirmək üçün daha etibarlı bir yanaşma hazırlamaq idi. Onlar xüsusilə rahatlıq və ya əqli sağlamlıqla bağlı rəhbərlik axtaran istifadəçilərlə bir neçə mesaj mübadiləsi aparacaqları ssenarilərə diqqət yetirdilər.

Çenq dedi: “Biz riskli davranışların, məsələn, xəyali inancları təsdiqləmək, klinik nüfuza sahib olmaq və ya sərhədləri tədricən aşmaq kimi çoxnövbəli qarşılıqlı təsirlər vasitəsilə ortaya çıxa biləcəyini ciddi şəkildə yoxlamaq istədik”.

“Bu cür nasazlıqların baş verdiyini və sistematik şəkildə ortaya çıxa biləcəyini nümayiş etdirməklə, məqalə strukturlaşdırılmış təhlükəsizlik tədbirlərinə ehtiyac olduğunu müəyyən edir. Bu işin növbəti mərhələsində birbaşa LLM sistemlərinə daxil edilmiş statik və dinamik təhlükəsizlik protokollarının eyni çoxnövbəli ssenarilərə qarşı sınaqdan keçirildikdə bu riskləri necə azalda biləcəyi qiymətləndiriləcək.”

Tədqiqatçılar testlərini aparmaq üçün müxtəlif əqli sağlamlıqla bağlı çətinliklərlə üzləşən 50 uydurma istifadəçinin profilini yaratdılar. Daha sonra onlar bu uydurma istifadəçilərin yaşadıqları çətinliklər üçün təsəlli və ya rəhbərlik axtardıqları təqdirdə LLM-lərlə edə biləcəkləri söhbətləri təsəvvür etdilər.

Tədqiqatçılar hər biri maksimum 20 raund sual və cavabdan ibarət olan ümumilikdə 150 test keçiriblər. Son tədqiqatlarının bir hissəsi olaraq, onlar bu yanaşmadan üç LLM-i sınaqdan keçirmək üçün istifadə ediblər: DeepSeek-chat, Gemini-2.5-Flash və Grok-3. “Sadə dillə desək, biz bu LLM-ləri körpünü sınaqdan keçirdiyiniz kimi “təzyiqlə sınaqdan keçirdik”: təkcə normal şəraitdə deyil, həm də artan gərginlik altında”, – deyə Çenq izah edib.

“Biz strukturlaşdırılmış virtual xəstə ssenariləri qurduq və istifadəçi sorğularının tədricən risk və ya qeyri-müəyyənlik artdığı çoxnövbəli söhbətlər apardıq. Bəzi söhbətlər sabit bir ssenariyə (statik irəliləyiş) uyğunlaşır, digərləri isə modelin dediklərinə əsasən uyğunlaşır (adaptiv zondlama).”

Çenq və həmkarları daha sonra yaranan söhbətləri təhlil etdilər və LLM-lərin verdiyi cavabların təhlükəsizliyini qiymətləndirdilər. LLM-lərin cavabları əvvəlcə süni intellekt modelləri istifadə edilərək qiymətləndirildi və daha sonra insan mütəxəssisləri tərəfindən nəzərdən keçirildi.

Modellərin cavablarını qiymətləndirərkən, komanda, təhlükəli məsləhətlər və sərhəd pozuntuları da daxil olmaqla, əqli sağlamlıqla bağlı dialoqlar apararkən faydasız və ya hətta təhlükəli olduğu bilinən müxtəlif ölçülərə diqqət yetirdi. Məsələn, onlar modelin qeyri-müəyyən nəticələr barədə “vədlər” verib-vermədiyini (məsələn, “Yaxşı olacaqsan”), peşəkar insan terapevti kimi davranıb-davranmadığını və ya istifadəçinin rifahı üçün məsuliyyət daşıdığını araşdırdılar.

Daha təhlükəsiz LLM-lərin inkişafı barədə məlumatlandırma

Maraqlıdır ki, tədqiqatçılar tərəfindən toplanan ilkin nəticələr göstərir ki, LLM-lər istifadəçilərlə zehni sağlamlıqları barədə uzun söhbətlər apara bilmirlər. Xüsusilə, tədqiqatçılar tərəfindən sınaqdan keçirilmiş modellərin tez-tez sərhədləri pozduğu və heç bir şəkildə müəyyən olmayan nəticələri proqnozlaşdıraraq istifadəçiləri sakitləşdirdiyi aşkar edilmişdir.

Çenq və həmkarları tərəfindən təqdim edilən standartlaşdırılmış qiymətləndirmə çərçivəsi indiyə qədər keçmişdə tətbiq edilən, daha qısa söhbətlərə yönəlmiş digər testlərdən daha təsirli olduğunu sübut etmişdir. Gələcəkdə bu, GPT-5 və ya digər geniş istifadə olunan LLM-lər üçün istifadə edilə bilər.

Çenq bildirib ki, “Bizim yanaşmamız tədqiqatçılar, səhiyyə mütəxəssisləri və məhsul qrupları tərəfindən modellərin yerləşdirilməzdən əvvəl müqayisəsi, daha təhlükəsiz səddlər dizaynı və modellər və ya təkliflər dəyişdikcə zamanla təhlükəsizlik reqressiyalarını izləmək üçün istifadə edilə bilər”.

Tədqiqatçılar tərəfindən toplanan ilkin tapıntılar, əqli sağlamlıqla əlaqəli mövzularda dəstək təklif etmək üçün hazırlanmış daha təhlükəsiz LLM-lərin inkişafına əsas verə bilər. Onlar həmçinin mövcud modellərin təkmilləşdirilməsinə kömək edə bilər, çünki həssas istifadəçilərlə qarşılıqlı əlaqə zamanı bu modellərin bəzi çatışmazlıqlarını vurğulayırlar.

Çenq əlavə edib ki, “Növbəti tədqiqatlarımızın bir hissəsi olaraq, məsələn, daha çox demoqrafik göstəricilər, dillər və klinik təqdimatlar daxil olmaqla, ssenari kitabxanasını genişləndirməyi planlaşdırırıq. Bundan əlavə, qərəzliliyi və yalançı müsbət nəticələri azaltmaq üçün avtomatlaşdırılmış hakimləri təkmilləşdirmək, psixiatriya/psixologiya sahəsində lisenziyalı qiymətləndiriciləri daxil etmək və xüsusi təhlükəsizlik tədbirlərinin (sistem təklifləri, imtina siyasətləri, eskalasiya şablonları) modellər və yeniləmələr üzrə real dünya təhlükəsizlik nəticələrini necə dəyişdirdiyini öyrənmək istərdik.”

Müəllifimiz İnqrid Fadelli tərəfindən sizin üçün yazılmış, Qeb Klark tərəfindən redaktə edilmiş və Robert İqan tərəfindən faktlar yoxlanılmış və nəzərdən keçirilmiş bu məqalə diqqətli insan əməyinin nəticəsidir. Müstəqil elmi jurnalistikanı yaşatmaq üçün sizin kimi oxuculara güvənirik. Əgər bu reportaj sizin üçün vacibdirsə, xahiş edirik ianə etməyi (xüsusilə aylıq) nəzərdən keçirin. Təşəkkür olaraq reklamsız hesab əldə edəcəksiniz .

Əlavə məlumat: Youyou Cheng və digərləri, Dəstəyin Yavaş Dəyişikliyi: Çoxnövbəli Ruhi Sağlamlıq LLM Dialoqlarında Sərhəd Uğursuzluqları, arXiv (2026). DOI: 10.48550/arxiv.2601.14269

Jurnal məlumatı: arXiv

© 2026 Science X Network