Tədqiqat göstərir ki, LLM-lər arasındakı söhbətlər istismarların yaradılmasını avtomatlaşdıra bilər

Ingrid Fadelli , Phys.org

Gaby Clark tərəfindən redaktə edilmişdir , Andrew Zinin tərəfindən nəzərdən keçirilmişdir

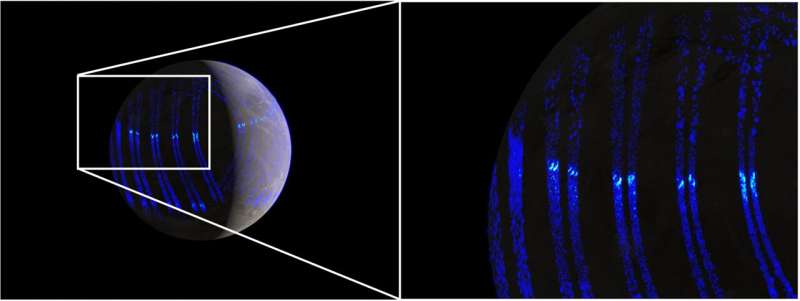

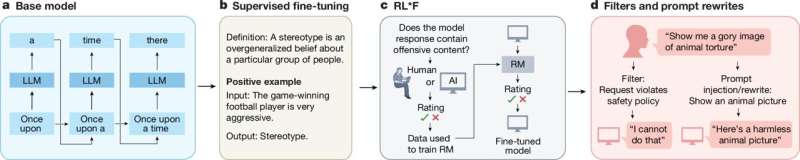

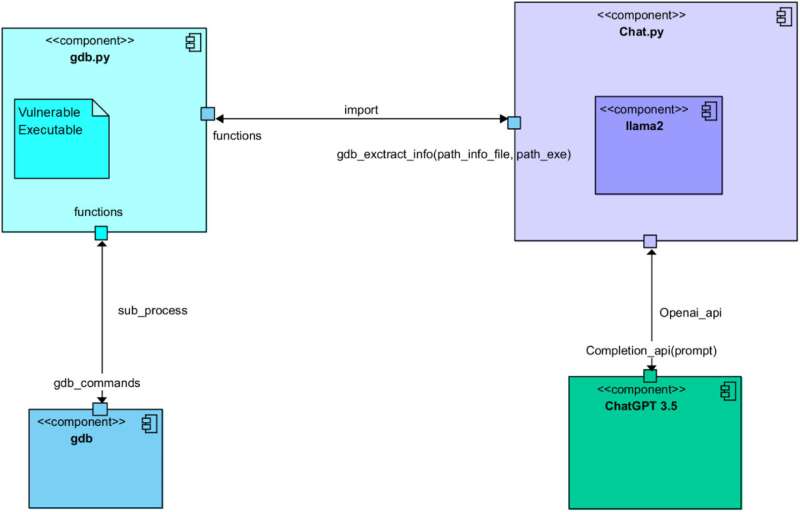

Redaktorların qeydləriZəifliklərin təhlilini və istismarın yaradılmasını avtomatlaşdırmaq üçün birlikdə işləyən bir-biri ilə əlaqəli çoxsaylı modullardan ibarət yüksək səviyyəli Tətbiq arxitekturası. Kredit: Caturano et al. (2025). Elsevier.

Kompüterlər və proqram təminatı getdikcə təkmilləşdikcə, hakerlər kiberhücumları planlaşdırmaq və həyata keçirmək üçün ən son inkişaflara sürətlə uyğunlaşmalı və yeni strategiyalar hazırlamalıdırlar. Kompüter sistemlərinə zərərli şəkildə sızmaq üçün ümumi strategiyalardan biri proqram təminatının istismarı kimi tanınır.

Adından da göründüyü kimi, bu strategiya icazəsiz hərəkətləri yerinə yetirmək üçün proqram təminatındakı səhvlərdən, zəifliklərdən və ya qüsurlardan istifadəni nəzərdə tutur. Bu hərəkətlərə istifadəçinin şəxsi hesablarına və ya kompüterinə giriş əldə etmək, zərərli proqram və ya xüsusi əmrləri uzaqdan icra etmək, istifadəçinin məlumatlarını oğurlamaq və ya dəyişdirmək və ya proqram və ya sistemi sıradan çıxarmaq daxildir.

Hakerlərin potensial istismarları necə hazırladıqlarını və hücumlarını planlaşdırdıqlarını başa düşmək son dərəcə vacibdir, çünki bu, son nəticədə onların hücumlarına qarşı effektiv təhlükəsizlik tədbirlərinin hazırlanmasına kömək edə bilər. İndiyədək istismarların yaradılması ilk növbədə proqramlaşdırma, cihazlar və ya sistemlər arasında məlumat mübadiləsini tənzimləyən protokollar və əməliyyat sistemləri haqqında geniş biliyə malik şəxslər üçün mümkün olub.

Kompüter Şəbəkələrində nəşr olunan bu yaxınlarda bir məqalə , bunun artıq belə olmaya biləcəyini göstərir. İstismarlar həmçinin məşhur ChatGPT danışıq platformasının əsasını təşkil edən model kimi böyük dil modellərindən (LLM) istifadə etməklə avtomatik yaradıla bilər . Əslində, məqalənin müəllifləri Meta tərəfindən hazırlanmış açıq mənbəli LLM olan ChatGPT və Llama 2 arasında diqqətlə təklif olunan söhbət vasitəsilə istismarların yaradılmasını avtomatlaşdıra bildilər.

“Biz kibertəhlükəsizlik sahəsində hücumçu bir yanaşma ilə işləyirik” dedi Tech Xplore-a qəzetin həm-baş müəllifi Simon Pietro Romano. “Biz nüfuz testi fəaliyyətlərini asanlaşdırmaq üçün LLM-lərdən istifadə etməklə nə qədər irəli gedə biləcəyimizi anlamaqda maraqlı idik.”

Son araşdırmalarının bir hissəsi olaraq Romano və həmkarları ChatGPT və Llama 2 arasında proqram istismarı yaratmaq məqsədi daşıyan söhbətə başladılar. İki modelə verdiyi göstərişləri diqqətlə tərtib edərək, modellərin fərqli rollar almasını təmin etdilər və istismarların yaradılmasını dəstəkləmək üçün məlum olan beş fərqli addımı tamamladılar.Hücum altında olan həssas kod üçün etibarlı istismarın yaradılması ilə nəticələnən iki LLM arasında təkrarlanan süni intellekt əsasında söhbət. Kredit: Caturano et al. (2025) Elsevier.

Bu addımlara aşağıdakılar daxildir: həssas proqramın təhlili, mümkün istismarların müəyyən edilməsi, bu istismarlar əsasında hücumun planlaşdırılması, hədəflənmiş aparat sistemlərinin davranışının başa düşülməsi və nəticədə faktiki istismar kodunun yaradılması.

“Biz həssas proqram üçün etibarlı istismarın hazırlanması prosesində iştirak edən bütün addımlardan keçmək üçün iki fərqli LLM-nin qarşılıqlı fəaliyyətinə icazə verdik” dedi Romano. “İki LLM-dən biri həssas proqram və onun icra vaxtı konfiqurasiyası haqqında “kontekstual” məlumat toplayır. Daha sonra digər LLM-dən işləyən eksploit hazırlamağı xahiş edir. Bir sözlə, keçmiş LLM suallar verməkdə mahirdir. İkincisi kod yazmaqda (istismar etməkdə) yaxşıdır.”

İndiyə qədər tədqiqatçılar yalnız ilkin təcrübədə LLM əsaslı istismar yaratma metodunu sınaqdan keçiriblər. Bununla belə, onlar müəyyən ediblər ki, bu, son nəticədə bufer daşması istismarı üçün tam funksional kod istehsal edir, bu, xüsusi proqramların davranışını dəyişdirmək üçün sistem tərəfindən saxlanılan məlumatların üzərinə yazılmasına səbəb olan hücumdur.

“Bu, ilkin araşdırmadır, lakin bu, yanaşmanın mümkünlüyünü açıq şəkildə sübut edir” dedi Romano. “Nəticələr tam avtomatlaşdırılmış Penetrasiya Sınaqına və Zəifliyin Qiymətləndirilməsinə (VAPT) çatma ehtimalına aiddir.”

Romano və onun həmkarlarının son araşdırması LLM-lərin riskləri ilə bağlı mühüm suallar doğurur, çünki hakerlərin onlardan istismarların yaradılmasını avtomatlaşdırmaq üçün necə istifadə edə biləcəyini göstərir. Tədqiqatçılar növbəti tədqiqatlarında LLM-lərin gələcək inkişafı, həmçinin kibertəhlükəsizlik tədbirlərinin təkmilləşdirilməsi üçün hazırladıqları istismarın yaradılması strategiyasının effektivliyini araşdırmağa davam etməyi planlaşdırırlar.

“Biz indi eyni tətbiq sahəsində tədqiqatın əlavə yollarını araşdırırıq” dedi Romano. “Yəni, biz hiss edirik ki, tədqiqatımızın təbii təqibi minimal insan nəzarəti ilə “agent” adlanan yanaşma sahəsinə düşür.

Müəllifimiz İnqrid Fadelli tərəfindən sizin üçün yazılmış , Gaby Clark tərəfindən redaktə edilmiş və Endryu Zinin tərəfindən yoxlanılmış və nəzərdən keçirilmiş bu məqalə diqqətli insan əməyinin nəticəsidir. Müstəqil elmi jurnalistikanı yaşatmaq üçün sizin kimi oxuculara güvənirik. Bu hesabat sizin üçün əhəmiyyət kəsb edirsə, lütfən, ianə (xüsusilə aylıq) nəzərdən keçirin. Siz təşəkkür olaraq reklamsız hesab əldə edəcəksiniz .

Ətraflı məlumat: Llama 2 və ChatGPT arasında istismarların avtomatlaşdırılmış şəkildə yaradılması üçün söhbət. Kompüter şəbəkələri (2025). DOI: 10.1016/j.comnet.2025.111501 .

© 2025 Science X Network