Təlimdən sonra LLM biliklərini redaktə etmək niyə qarışıq dalğa effektləri yarada bilər?

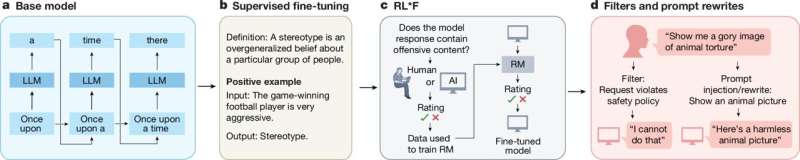

Open AI tərəfindən hazırlanmış asanlıqla əldə edilə bilən model olan ChatGPT-nin meydana çıxmasından sonra böyük dil modelləri (LLM) getdikcə geniş yayılmışdır və indi bir çox onlayn istifadəçilər sorğularına tez cavab almaq, mənbə məlumatı almaq və ya fərdi mətnlər hazırlamaq üçün onlara gündəlik daxil olurlar. Sözləri sürətlə müəyyən etmək və istifadəçinin sorğularına uyğun yazılı mətnlər yaratmaq qabiliyyətinə baxmayaraq, bu modellər tərəfindən verilən cavablar həmişə dəqiq və etibarlı olmur.

Bundan əlavə, bütün dünyada mövcud olan biliklər daim təkamüldədir. Beləliklə, bu modellər bəzən təlimdən sonra yayımlanan digər müvafiq və aktual məlumatlardan fərqli olaraq, təlim zamanı qidalandıqları barədə köhnəlmiş məlumatları bildirə bilər. LLM-lərin bu məhdudiyyətini aradan qaldırmaq və onların cavablarının etibarlılığını artırmaq üçün bəzi kompüter alimləri təlimlərini başa vurduqdan sonra bilik bazalarını redaktə etmək imkanlarını araşdırırlar .

Bu biliklərin redaktəsi (KE) müdaxilələri sonra LLM tərəfindən hazırlanmış bütün məzmuna təsir göstərərək dalğalanma effekti yaratmalıdır. Bu o deməkdir ki, modelin verilən mövzu ilə bağlı gələcək cavabları onun bilikləri dəyişdirildikdən sonra bu mövzu haqqında əldə etdiyi yeni məlumatları əks etdirməlidir.

Təəssüf ki, tədqiqatlar göstərir ki, bu dalğalanma effektləri həmişə baş vermir. Əslində, bu o deməkdir ki, model dəyişdirilmiş məlumatla bağlı birbaşa suallara düzgün cavab verə bilsə də, o, yeni məlumatlara dolayısı ilə toxunan cavablar da daxil olmaqla, yaratdığı bütün cavablarda əldə etdiyi yeni bilikləri əhatə etməyə bilər.

İllinoys Urbana-Şampeyn Universitetinin tədqiqatçıları bu yaxınlarda LLM biliklərinin redaktəsindən sonra dalğa effektlərinin uğurla həyata keçirilməsinin altında yatan prosesləri daha yaxşı başa düşməyə başladılar. Onların arXiv preprint serverində dərc olunmuş məqaləsi bu geniş istifadə olunan modellər haqqında biliklərin yenilənməsinə yönəlmiş gələcək səyləri məlumatlandıra bilər və beləliklə, bu modellərin təlimdən sonra təkmilləşdirilməsinə töhfə verə bilər.

https://googleads.g.doubleclick.net/pagead/ads?gdpr=0&us_privacy=1—&gpp_sid=-1&client=ca-pub-0536483524803400&output=html&h=135&slotname=2793866484&adk=675901022&adf=1873531024&pi=t.ma~as.2793866484&w=540&abgtt=6&fwrn=4&lmt=1722784958&rafmt=11&format=540×135&url=https%3A%2F%2Ftechxplore.com%2Fnews%2F2024-07-knowledge-llms-messy-ripple-effects.html&wgl=1&uach=WyJXaW5kb3dzIiwiMTAuMC4wIiwieDg2IiwiIiwiMTI3LjAuNjUzMy44OSIsbnVsbCwwLG51bGwsIjY0IixbWyJOb3QpQTtCcmFuZCIsIjk5LjAuMC4wIl0sWyJHb29nbGUgQ2hyb21lIiwiMTI3LjAuNjUzMy44OSJdLFsiQ2hyb21pdW0iLCIxMjcuMC42NTMzLjg5Il1dLDBd&dt=1722782760424&bpp=3&bdt=1133&idt=4513&shv=r20240731&mjsv=m202407290101&ptt=9&saldr=aa&abxe=1&cookie=ID%3D3b199fcd67477665%3AT%3D1722782760%3ART%3D1722784051%3AS%3DALNI_MYiVAjEyy4dUxgOksNR26c7Dw2QPA&eo_id_str=ID%3Dd042eab5cd0e9128%3AT%3D1722782760%3ART%3D1722784051%3AS%3DAA-AfjaezaeceO7ROnaS-eCO7629&prev_fmts=0x0%2C1423x739&nras=2&correlator=8612858911685&frm=20&pv=1&rplot=4&u_tz=240&u_his=1&u_h=900&u_w=1440&u_ah=860&u_aw=1440&u_cd=24&u_sd=1&dmc=8&adx=347&ady=1799&biw=1423&bih=739&scr_x=0&scr_y=0&eid=44759876%2C44759927%2C44759837%2C95334526%2C95334829%2C95337026%2C95337870%2C31085750%2C31084187%2C95337092%2C95339221%2C95336267%2C31078663%2C31078665%2C31078668%2C31078670&oid=2&pvsid=3415731175623205&tmod=1618482627&uas=0&nvt=3&ref=https%3A%2F%2Fphys.org%2F&fc=1920&brdim=0%2C0%2C0%2C0%2C1440%2C0%2C1440%2C860%2C1440%2C739&vis=1&rsz=%7C%7CpeEbr%7C&abl=CS&pfx=0&fu=128&bc=31&bz=1&td=1&tdf=0&psd=W251bGwsbnVsbCwibGFiZWxfb25seV80IiwxXQ..&nt=1&ifi=2&uci=a!2&btvi=1&fsb=1&dtd=M

Jiaxin Qin, Zixuan Zhang və onların həmkarları öz məqalələrində yazıblar: “Əvvəlki geniş tədqiqatlar biliklərin dəqiq və aktual qalmasını təmin etmək üçün dil modelləri (LM) üçün təlim sonrası biliklərin redaktəsinə (KE) diqqət yetirib”. “KE-də arzu olunan xüsusiyyət və açıq sual redaktə edilmiş LM-lərin dalğa effektlərini düzgün idarə etməsinə icazə verməkdir, burada LM-nin məntiqi cəhətdən əlaqəli biliklərinə dəqiq cavab verməsi gözlənilir. Bu yazıda biz əksər KE üsullarının niyə hələ də qarışıq dalğa effektləri yaratması sualına cavab veririk. “

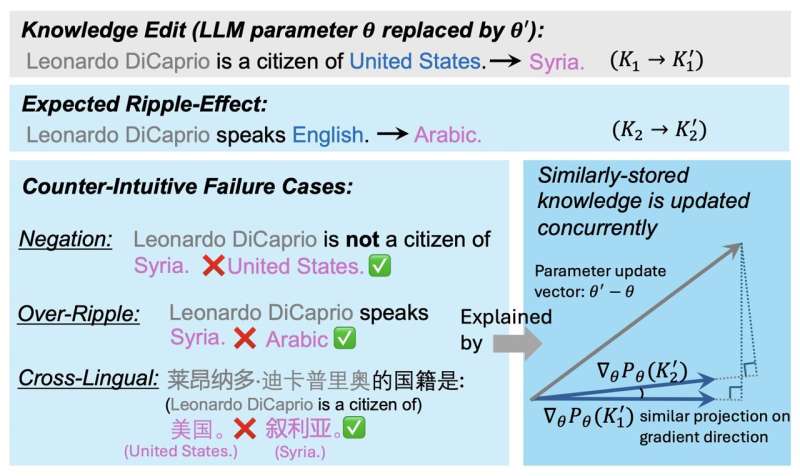

Bu yaxınlarda aparılan tədqiqatın əsas fərziyyəsi ondan ibarətdir ki, LLM-nin parametrləri arasında biliklərin saxlanması KE müdaxilələrinin istənilən dalğalanma effektlərinin nə dərəcədə olacağına təsir edir. Tədqiqatçılar öz məqalələrində yenilənmiş faktın məlumatı dəyişdirildikdən sonra LLM tərəfindən yaradılan cavablarda dalğalanma ehtimalını göstərə biləcək amili müəyyən edirlər.

Tədqiqatçıların GradSim adlandırdıqları bu amil mahiyyətcə əlaqəli bilik faktlarının gradientləri arasında kosinus oxşarlığıdır. Bir sıra testlər apararaq, komanda bu göstəricinin KE müdaxilələrindən sonra dalğalanma effektləri ilə güclü əlaqədə olduğunu nümayiş etdirdi.

“Biz geniş təhlil aparırıq və LM-lərdə yenilənmiş bilik dalğalarının nə vaxt və nə üçün olduğunu effektiv şəkildə aşkar edən əsas göstərici GradSim-i müəyyənləşdiririk” dedi tədqiqatçılar. “GradSim, orijinal faktın gradientləri və onunla əlaqəli biliklər arasındakı kosinus oxşarlığı ilə hesablanır. Biz müxtəlif LM-lər, KE metodları və qiymətləndirmə metrikləri üzrə dalğalanma effekti performansı ilə GradSim arasında güclü müsbət korrelyasiya müşahidə edirik. Üç əks-intuitiv uğursuzluqla bağlı əlavə araşdırmalar Ripple effektlərinin halları (İnkar, Over-Ripple, Multi-Lingual) göstərir ki, bu uğursuzluqlar çox vaxt çox aşağı GradSim ilə əlaqələndirilir.”

Qin, Zhang və onların həmkarları tərəfindən aparılan bu son araşdırma LLM-nin biliklərinin redaktə edilməsinin gələcək cavablarına nə dərəcədə təsir edəcəyini proqnozlaşdırmağa kömək edə biləcək mühüm amili təsvir edir. Komandanın tapıntıları, təlimləri başa çatdıqdan sonra LLM biliklərinin effektiv şəkildə yenilənməsinə yönəlmiş yeni səylər haqqında məlumat verə bilər.

Daha çox məlumat: Jiaxin Qin və digərləri, Niyə Yeni Bilik LLM-lərdə qarışıq dalğalanma effektləri yaradır?, arXiv (2024). DOI: 10.48550/arxiv.2407.12828

Jurnal məlumatı: arXiv