Texnologiya nəhəngləri süni intellektə nəzarət etmək üçün pəncərənin bağlandığını xəbərdar edir, hərəkətə keçməyə çağırır

Paul Arnold tərəfindən , Phys.org

Gaby Clark tərəfindən redaktə edilmişdir , Andrew Zinin tərəfindən nəzərdən keçirilmişdir

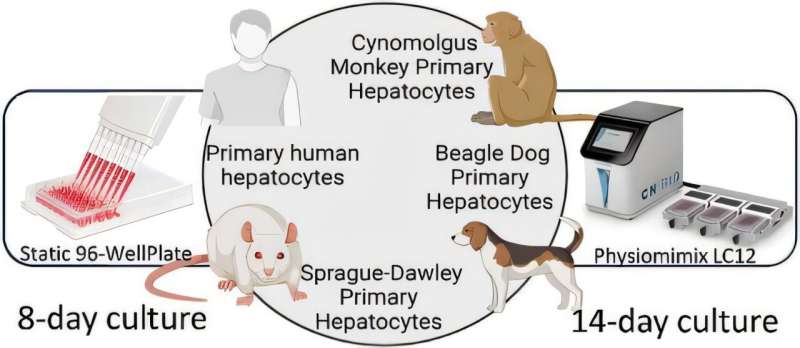

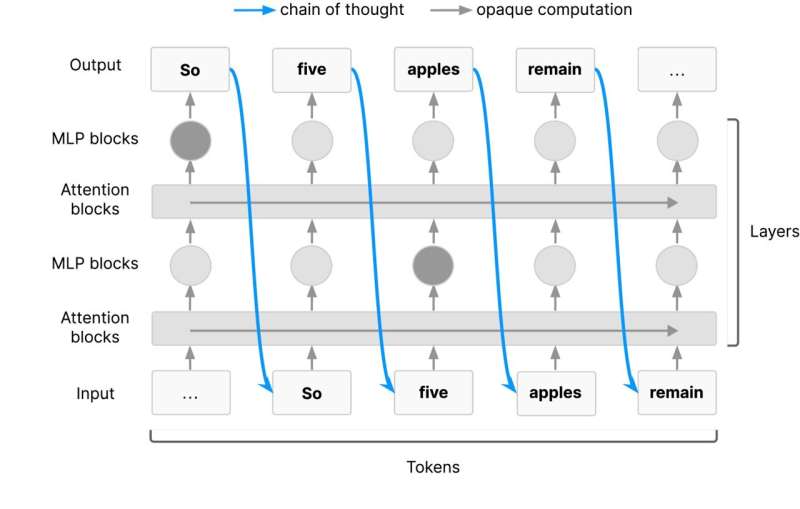

Redaktorların qeydləriUzun silsiləli idrak zəncirləri düşüncə zəncirindən keçməlidir. Kredit: arXiv (2025). DOI: 10.48550/arxiv.2507.11473

Süni intellekt başgicəlləndirici sürətlə irəliləyir. Bir çox yeni texnologiyalar kimi, o, əhəmiyyətli faydalar təklif edir, həm də təhlükəsizlik riskləri yaradır. Potensial təhlükələri dərk edərək, Google DeepMind, OpenAI, Meta, Anthropic və şirkətlər və qeyri-kommersiya qruplarının koalisiyasının aparıcı tədqiqatçıları süni intellekt sistemlərinin necə “düşündüyünü” izləmək üçün daha çox iş görülməsinə çağırış etmək üçün bir araya gəldilər.

Bu həftənin əvvəlində dərc edilən və tanınmış sənaye xadimləri, o cümlədən Geoffrey Hinton (geniş şəkildə “AI-nin xaç atası” kimi qəbul edilir) və OpenAI-nin həmtəsisçisi İlya Sutskever tərəfindən təsdiqlənən birgə məqalədə elm adamları süni intellektə əsaslanmağa nəzarət etmək üçün qısa bir pəncərənin tezliklə bağlana biləcəyini iddia edirlər.

AI monitorinqinin təkmilləşdirilməsi

Onlar insanların çətin riyaziyyat problemi kimi mürəkkəb tapşırıqları yerinə yetirməsi kimi, süni intellekt modellərinə mürəkkəb problemləri daha kiçik addımlara bölmək yolu ilə həll etməyə imkan verən bir texnika olan düşüncə zəncirlərinin (CoTs) daha çox monitorinqinə çağırırlar .

CoTs DeepSeek R1 və Dil Öyrənmə Modelləri (LLM) daxil olmaqla qabaqcıl AI modellərinin əsas xüsusiyyətləridir. Bununla belə, süni intellekt sistemləri daha da təkmilləşdikcə, onların qərar vermə proseslərini şərh etmək daha da çətinləşəcək. Bu, narahatlıq doğurur, çünki mövcud süni intellektə nəzarət üsulları qeyri-kamildir və yanlış davranışı əldən verə bilər.

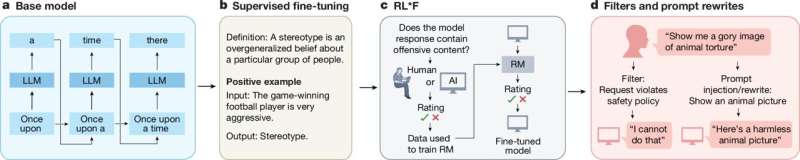

Məqalədə elm adamları, modellərin “ təlim zamanı mükafat funksiyalarında çatışmazlıqlardan istifadə edərək” və ya “nəticəyə nail olmaq üçün məlumatların manipulyasiyası” ilə yanlış uyğunlaşdırılmış şəkildə hərəkət etməsi kimi süni intellektlə bağlı səhv davranış nümunələrini aşkar etməklə CoT monitorinqinin artıq öz dəyərini necə sübut etdiyini vurğuladılar.

Alimlər hesab edirlər ki, CT-lərin daha yaxşı monitorinqi süni intellekt agentlərini daha bacarıqlı olduqları üçün nəzarət altında saxlamaq üçün dəyərli bir yol ola bilər.

“Fikir zəncirinin monitorinqi sərhəd süni intellekt üçün təhlükəsizlik tədbirlərinə dəyərli əlavə təqdim edir , süni intellekt agentlərinin necə qərarlar qəbul etdiyinə dair nadir bir fikir təqdim edir” dedi tədqiqatçılar öz məqalələrində. “Hələ indiki görünmə dərəcəsinin davam edəcəyinə heç bir zəmanət yoxdur. Biz tədqiqat ictimaiyyətini və sərhəd süni intellekt tərtibatçılarını CoT monitorinqindən ən yaxşı şəkildə istifadə etməyə və onun necə qorunub saxlanıla biləcəyini öyrənməyə təşviq edirik.”

Tədqiqatçıların əsas tələblərindən biri süni intellekt tərtibatçılarının CoT-ləri nəyin izlənilə biləcəyini öyrənmələridir. Başqa sözlə, AI modellərinin cavablarına necə gəldiyini necə daha yaxşı başa düşə bilərik? Onlar həmçinin tərtibatçılardan CoT monitorinqinin təhlükəsizlik tədbiri kimi necə daxil edilə biləcəyini öyrənmələrini istəyirlər.

Birgə sənəd, şiddətli rəqabət aparan texnologiya nəhəngləri arasında nadir bir birlik anını qeyd edərək, onların təhlükəsizliklə bağlı nə qədər narahat olduqlarını vurğulayır. Süni intellekt sistemləri daha güclü və cəmiyyətə inteqrasiya etdikcə, onların təhlükəsizliyinin təmin edilməsi heç vaxt bu qədər vacib və təcili olmamışdır.

Müəllifimiz Paul Arnold tərəfindən sizin üçün yazılmış , Gaby Clark tərəfindən redaktə edilmiş və Endryu Zinin tərəfindən yoxlanılmış və nəzərdən keçirilmiş bu məqalə diqqətli insan əməyinin nəticəsidir. Müstəqil elmi jurnalistikanı yaşatmaq üçün sizin kimi oxuculara güvənirik. Bu hesabat sizin üçün əhəmiyyət kəsb edirsə, lütfən, ianə (xüsusilə aylıq) nəzərdən keçirin. Siz təşəkkür olaraq reklamsız hesab əldə edəcəksiniz .

Daha çox məlumat: Tomek Korbak et al, Chain of Thought Monitorability: A New and Fragile Opportunity for AI Safety, arXiv (2025). DOI: 10.48550/arxiv.2507.11473

Jurnal məlumatı: arXiv

© 2025 Science X Network