Yeni araşdırma süni intellektin özünə inam problemi olduğunu ortaya qoyur

Paul Arnold tərəfindən , Phys.org

Lisa Lock tərəfindən redaktə edilmişdir , Andrew Zinin tərəfindən nəzərdən keçirilmişdir

Redaktorların qeydləriKredit: Pexels-dən Pavel Danilyuk

Google DeepMind və London Universitet Kollecinin tədqiqatçılarının yeni araşdırmasına görə, böyük dil modelləri (LLM) bəzən suallara cavab verərkən özünə inamını itirir və düzgün cavablardan imtina edir.

LLMs insan dilini anlayan və yaradan güclü AI sistemləridir . Onlar maliyyə, səhiyyə və informasiya texnologiyaları kimi bir sıra sənaye sahələrində əsaslandırma və qərar qəbul etməyi tələb edən tapşırıqlar üçün istifadə olunur. Buna görə də, onların dəqiqliyi və etibarlılığı hər şeydən üstündür, yəni onlar öz cavablarında ardıcıl olaraq əmin olmalıdırlar. Bununla belə, tərəddüd edə bilərlər.

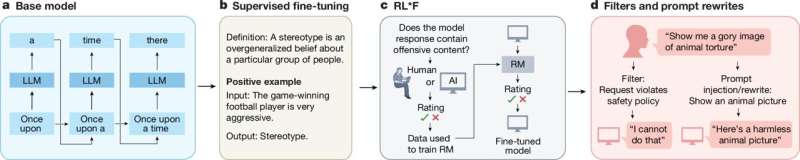

LLM-lərin təhlükəsiz yerləşdirilməsi üçün onların cavabları etibarlılıq balları ilə müşayiət olunur. Lakin onların davranışlarını istiqamətləndirmək üçün onlardan necə istifadə etdikləri aydın deyil.

arXiv preprint serverinə yerləşdirilən bu araşdırma göstərir ki, onlar ilkin cavablarında həddən artıq arxayın ola bilərlər, lakin yanlış əks-arqument təqdim olunduqda inamlarını itirirlər və fikirlərini dəyişirlər.

LLM inamının sınaqdan keçirilməsi

Bu aşkar paradoksu araşdırmaq üçün tədqiqatçılar LLM-lərin öz inamlarını necə yenilədiklərini və kənar məsləhətlər təqdim olunduqda cavablarını dəyişdirib-dəyişdirməmələrinə qərar vermələrini sınaqdan keçirdilər.

Əvvəlcə “cavab verən LLM”yə ikili seçim sualı verildi. Cavab verdikdən sonra o, dəqiqlik reytinqi ilə müşayiət olunan ikinci LLM-dən məsləhət aldı. Bu “məsləhət LLM” də cavab verən LLM-nin ilk cavabı ilə razılaşacaq, ona qarşı çıxacaq və ya neytral olacaq. Sonra cavab verən LLM-dən son seçim etmək istəndi. Tədqiqatçılar, həmçinin LLM-nin son qərarını verərkən ilk cavabını görüb-görmədiyini də fərqləndirdilər.

Nəticələr

Tədqiqat göstərdi ki, LLM-lər ilkin cavablarına daha çox sadiq qalırlar və gizləndiklərindən daha çox görünəndə dəyişmirlər. Başqa sözlə, daha inamlı olurlar. Tədqiqat onu da göstərdi ki, modellərə müxalif məsləhətlər verildikdə, onlar çox vaxt inamlarını itirir və qərarlarını dəyişirlər. Məsləhət dəstəkləyəndən daha çox bunu daha asan edirlər. Bu nümunələr Gemma 3, GPT4o və o1-preview kimi bir neçə fərqli LLM-də görüldü.

“Nəticələrimiz göstərir ki, LLM-lər bir neçə əhəmiyyətli şəkildə normativ davranışdan kənara çıxırlar: birincisi, onlar öz cavablarına inamlarını artıran və hətta əksinə dəlillərin mövcudluğunda belə onlara sadiq qalmalarına səbəb olan təəccüblü seçimi dəstəkləyən qərəz nümayiş etdirirlər” dedi tədqiqatçılar.

“İkincisi, biz göstəririk ki, LLM-lər yeni məlumatları öz inanclarına inteqrasiya etsələr də, bunu optimal olmayan tərzdə edirlər: onlar ideal müşahidəçidən kənara çıxan etimad yeniləmələrinin profilini nümayiş etdirirlər və əks məsləhətləri nəzərəçarpacaq dərəcədə artırırlar ki, bu da onların ilkin cavablarına inamın kəskin şəkildə itirilməsi ilə nəticələnir.”

Daha yaxşı AI yaratmaq

Bütün bunlar əhəmiyyətlidir, çünki bir çox sənaye LLM-lərdən getdikcə daha çox asılıdır. Ancaq bu araşdırma göstərir ki, onlar sırf məntiqi maşınlar deyil. Onların öz qərəzləri var və yırğalana bilərlər. Buna görə də, insan və süni intellekt agenti arasındakı uzun söhbətlərdə ən son məlumat onun reaksiyasına qeyri-mütənasib təsir göstərə bilər.

LLM qərarlarının qəbul edilməsinin bu və digər nüanslarını başa düşmək daha yaxşı, daha təhlükəsiz və daha etibarlı AI sistemlərinin dizaynına kömək edə bilər.

Müəllifimiz Pol Arnold tərəfindən sizin üçün yazılmış , Liza Lok tərəfindən redaktə edilmiş və Endryu Zinin tərəfindən yoxlanılmış və nəzərdən keçirilmiş bu məqalə diqqətli insan əməyinin nəticəsidir. Müstəqil elmi jurnalistikanı yaşatmaq üçün sizin kimi oxuculara güvənirik. Bu hesabat sizin üçün əhəmiyyət kəsb edirsə, lütfən, ianə (xüsusilə aylıq) nəzərdən keçirin. Siz təşəkkür olaraq reklamsız hesab əldə edəcəksiniz .

Daha çox məlumat: Dharshan Kumaran et al, İlkin seçimlərə həddindən artıq inam və tənqid altında inamsızlıq, böyük dil modellərində düşüncə dəyişikliyini necə modullaşdırır, arXiv (2025). DOI: 10.48550/arxiv.2507.03120

Jurnal məlumatı: arXiv

© 2025 Science X Network